© gorodenkoff - iStock Getty Images Plus

La loi sur l’IA vise à fournir aux développeurs et aux déployeurs d’IA des exigences et des obligations claires concernant les utilisations spécifiques de l’IA. Dans le même temps, le règlement vise à réduire les charges administratives et financières pour les entreprises, en particulier les petites et moyennes entreprises (PME).

La loi sur l’IA fait partie d’un ensemble plus large de mesures politiques visant à soutenir le développement d’une IA digne de confiance, qui comprend également le train de mesures sur l’innovation dans le domaine de l’IA et le plan coordonné en matière d’IA. Ensemble, ces mesures garantiront la sécurité et les droits fondamentaux des personnes et des entreprises en matière d’IA. Ils renforceront également l’adoption, l’investissement et l’innovation dans l’IA dans l’ensemble de l’UE.

La loi sur l’IA est le tout premier cadre juridique complet sur l’IA au monde. L’objectif des nouvelles règles est de promouvoir une IA digne de confiance en Europe et au-delà, en veillant à ce que les systèmes d’IA respectent les droits fondamentaux, la sécurité et les principes éthiques et en s’attaquant aux risques liés à des modèles d’IA très puissants et percutants.

Pourquoi avons-nous besoin de règles sur l’IA?

La loi sur l’IA garantit que les Européens peuvent faire confiance à ce que l’IA a à offrir. Alors que la plupart des systèmes d’IA sont limités à aucun risque et peuvent contribuer à résoudre de nombreux défis sociétaux, certains systèmes d’IA créent des risques auxquels nous devons nous attaquer pour éviter les résultats indésirables.

Par exemple, il est souvent impossible de savoir pourquoi un système d’IA a pris une décision ou une prédiction et a pris une mesure particulière. Il peut donc devenir difficile d’évaluer si une personne a été injustement désavantagée, par exemple dans une décision d’embauche ou dans une demande de régime d’utilité publique.

Bien que la législation existante fournisse une certaine protection, elle est insuffisante pour relever les défis spécifiques que les systèmes d’IA peuvent présenter.

Les règles proposées:

- traiter les risques spécifiquement créés par les applications d’IA;

- interdire les pratiques d’IA qui présentent des risques inacceptables;

- établir une liste d’applications à haut risque;

- définir des exigences claires pour les systèmes d’IA pour les applications à haut risque;

- définir des obligations spécifiques pour les déployeurs et les fournisseurs d’applications d’IA à haut risque;

- exiger une évaluation de la conformité avant la mise en service ou la mise sur le marché d’un système d’IA donné;

- mettre l’application en place après la mise sur le marché d’un système d’IA donné;

- mettre en place une structure de gouvernance aux niveaux européen et national.

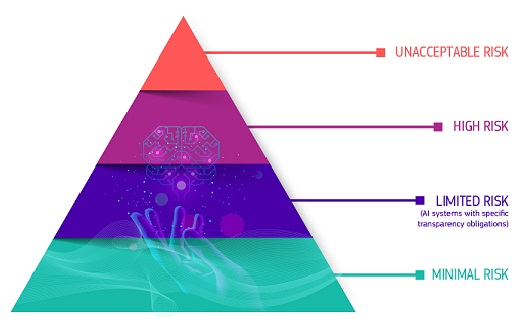

Une approche fondée sur les risques

Le cadre réglementaire définit quatre niveaux de risque pour les systèmes d’IA:

Tous les systèmes d’IA considérés comme une menace évidente pour la sécurité, les moyens de subsistance et les droits des personnes seront interdits, de la notation sociale par les gouvernements aux jouets utilisant l’assistance vocale qui encouragent les comportements dangereux.

Risque élevé

Les systèmes d’IA identifiés comme à haut risque comprennent la technologie de l’IA utilisée dans:

- les infrastructures critiques (par exemple les transports), susceptibles de mettre en danger la vie et la santé des citoyens;

- la formation éducative ou professionnelle, qui peut déterminer l’accès à l’éducation et au cours professionnel de la vie d’une personne (par exemple, la notation des examens);

- composants de sécurité des produits (par exemple, application d’IA en chirurgie assistée par robot);

- l’emploi, la gestion des travailleurs et l’accès au travail indépendant (par exemple, un logiciel de tri de CV pour les procédures de recrutement);

- services publics et privés essentiels (par exemple, notation de crédit refusant aux citoyens la possibilité d’obtenir un prêt);

- les services répressifs susceptibles d’interférer avec les droits fondamentaux des personnes (par exemple, évaluation de la fiabilité des preuves);

- gestion de la migration, de l’asile et du contrôle aux frontières (par exemple, examen automatisé des demandes de visa);

- administration de la justice et processus démocratiques (par exemple, solutions d’IA pour rechercher des décisions de justice).

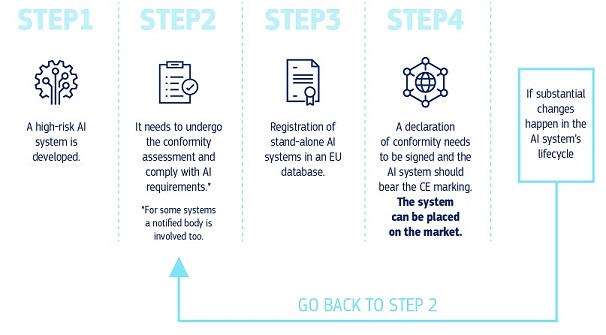

Les systèmes d’IA à haut risque seront soumis à des obligations strictes avant de pouvoir être mis sur le marché:

- des systèmes adéquats d’évaluation et d’atténuation des risques;

- haute qualité des ensembles de données alimentant le système afin de minimiser les risques et les résultats discriminatoires;

- l’enregistrement des activités afin d’assurer la traçabilité des résultats;

- une documentation détaillée fournissant toutes les informations nécessaires sur le système et son objet pour permettre aux autorités d’évaluer sa conformité;

- des informations claires et adéquates à l’intention du déployeur;

- des mesures de surveillance humaines appropriées pour minimiser les risques;

- haut niveau de robustesse, de sécurité et de précision.

Tous les systèmes d’identification biométrique à distance sont considérés comme à haut risque et soumis à des exigences strictes. L’utilisation de l’identification biométrique à distance dans des espaces accessibles au public à des fins répressives est, en principe, interdite.

Des exceptions étroites sont strictement définies et réglementées, par exemple lorsque cela est nécessaire pour rechercher un enfant disparu, pour prévenir une menace terroriste spécifique et imminente ou pour détecter, localiser, identifier ou poursuivre un auteur ou un suspect d’une infraction pénale grave.

Ces utilisations sont soumises à l’autorisation d’un organe judiciaire ou autre organisme indépendant et à des limites appropriées dans le temps, la portée géographique et les bases de données recherchées.

Risque limité

Un risque limité rrenvoie aux risques associés au manque de transparence dans l’utilisation de l’IA. La loi sur l’IA introduit des obligations spécifiques en matière de transparence afin de garantir que les êtres humains sont informés lorsque cela est nécessaire, ce qui favorise la confiance. Par exemple, lors de l’utilisation de systèmes d’IA tels que les chatbots, les humains doivent être informés qu’ils interagissent avec une machine afin qu’ils puissent prendre une décision éclairée de continuer ou de prendre du recul. Les fournisseurs devront également s’assurer que le contenu généré par l’IA est identifiable. En outre, les textes générés par l’IA publiés dans le but d’informer le public sur des questions d’intérêt public doivent être étiquetés comme étant générés artificiellement. Cela s’applique également aux contenus audio et vidéo constituant des contrefaçons profondes.

Risque minimal ou nul

La loi sur l’IA permet l’utilisation gratuite de l’IA à risque minimal. Cela inclut des applications telles que les jeux vidéo compatibles avec l’IA ou les filtres anti-spam. La grande majorité des systèmes d’IA actuellement utilisés dans l’UE relèvent de cette catégorie.

Comment tout cela fonctionne-t-il dans la pratique pour les fournisseurs de systèmes d’IA à haut risque?

Une fois qu’un système d’IA est sur le marché, les autorités sont en charge de la surveillance du marché, les déployeurs assurent la surveillance et le suivi humains, et les fournisseurs ont mis en place un système de surveillance post-commercialisation. Les fournisseurs et les déployeurs signaleront également des incidents graves et des dysfonctionnements.

Une solution pour l’utilisation digne de confiance des grands modèles d’IA

De plus en plus, les modèles d’IA à usage général deviennent des composants des systèmes d’IA. Ces modèles peuvent effectuer et adapter d’innombrables tâches différentes.

Alors que les modèles d’IA à usage général peuvent permettre des solutions d’IA meilleures et plus puissantes, il est difficile de superviser toutes les capacités.

Dans ce cadre, la loi sur l’IA introduit des obligations de transparence pour tous les modèles d’IA à usage général afin de permettre une meilleure compréhension de ces modèles et des obligations supplémentaires en matière de gestion des risques pour les modèles très capables et percutants. Ces obligations supplémentaires comprennent l’autoévaluation et l’atténuation des risques systémiques, la notification des incidents graves, la réalisation d’évaluations de tests et de modèles, ainsi que les exigences en matière de cybersécurité.

Législation à l’épreuve du temps

Étant donné que l’IA est une technologie en évolution rapide, la proposition a une approche à l’épreuve du temps, permettant aux règles de s’adapter aux changements technologiques. Les applications d’IA devraient rester dignes de confiance même après leur mise sur le marché. Cela nécessite une gestion continue de la qualité et des risques par les fournisseurs.

Application et mise en œuvre

L’ Office européen de l’IA, créé en février 2024 au sein de la Commission, supervise l’application et la mise en œuvre de la loi sur l’IA avec les États membres. Il vise à créer un environnement où les technologies de l’IA respectent la dignité humaine, les droits et la confiance. Il favorise également la collaboration, l’innovation et la recherche en IA entre les différentes parties prenantes. En outre, il participe au dialogue et à la coopération internationaux sur les questions liées à l’IA, reconnaissant la nécessité d’un alignement mondial sur la gouvernance de l’IA. Grâce à ces efforts, le Bureau européen de l’IA s’efforce de positionner l’Europe en tant que leader dans le développement éthique et durable des technologies de l’IA.

Prochaines étapes

En décembre 2023, le Parlement européen et le Conseil de l’UE sont parvenus à un accord politique sur la loi sur l’IA. Le texte est en cours d’adoption et de traduction formelles. La loi sur l’IA entrera en vigueur 20 jours après sa publication au Journal officiel et sera pleinement applicable deux ans plus tard, à quelques exceptions près: les interdictions entreront en vigueur après six mois, les règles de gouvernance et les obligations relatives aux modèles d’IA à usage général deviendront applicables après 12 mois et les règles applicables aux systèmes d’IA — intégrés dans des produits réglementés — s’appliqueront après 36 mois. Afin de faciliter la transition vers le nouveau cadre réglementaire, la Commission a lancé le pacte sur l’IA, une initiative volontaire qui vise à soutenir la mise en œuvre future et invite les développeurs d’IA d’Europe et d’ailleurs à se conformer à l’avance aux principales obligations de la loi sur l’IA.

Dernières nouvelles

Rapport / Etude

- 05-04-2024L’IA pour le bien public: Alliance de recherche UE-États-Unis sur l’IA pour le bien public

- 30-11-2023Le potentiel de l’Europe en Edge Computing: Soutenir l’innovation industrielle au moyen de projets pilotes à grande échelle

- 30-11-2023Trends in advanced manufacturing Research and Innovation

Fiche d’information / infographie

- 05-04-2024Fiche d’information: Conseil du commerce et de la technologie UE-États-Unis (2021-2024)

- 21-02-2024Fiche d’information sur le paquet «Connectivité» sur les réseaux et infrastructures numériques

- 31-05-2023Conseil du commerce et des technologies UE-États-Unis — Quatrième réunion ministérielle — Résultats clés

Contenu associé

Vue d’ensemble

L’approche de l’UE en matière d’intelligence artificielle est axée sur l’excellence et la confiance, visant à renforcer la recherche et les capacités industrielles tout en garantissant la sécurité et les droits fondamentaux.

Aller plus loin

Le pacte sur l’IA encouragera et aidera les entreprises à planifier à l’avance les mesures prévues par la loi sur l’IA.

À lire également

L’initiative internationale en faveur de l’intelligence artificielle centrée sur l’homme contribuera à promouvoir la vision de l’UE en matière d’IA durable et digne de confiance.

Le plan coordonné sur l’intelligence artificielle vise à accélérer les investissements dans l’IA, à mettre en œuvre des stratégies et des programmes d’IA et à aligner la politique d’IA afin de prévenir la fragmentation en Europe.

La Commission européenne a nommé un groupe d’experts chargé de fournir des conseils sur sa stratégie en matière d’intelligence artificielle.

L’Alliance européenne pour l’IA est une initiative de la Commission européenne visant à établir un dialogue politique ouvert sur l’intelligence artificielle. Depuis son lancement en 2018, l’Alliance AI a mobilisé environ 6000 parties prenantes à travers des événements réguliers...