Akt o umelej inteligencii je vôbec prvým právnym rámcom pre umelú inteligenciu, ktorý rieši riziká spojené s umelou inteligenciou a stavia Európu do vedúcej pozície na celosvetovej úrovni.

Akt o umelej inteligencii [nariadenie (EÚ) 2024/1689, ktorým sa stanovujú harmonizované pravidlá v oblasti umelej inteligencie] je vôbec prvým komplexným právnym rámcom pre umelú inteligenciu na svete. Cieľom pravidiel je podporiť dôveryhodnú umelú inteligenciu v Európe.

V akte o umelej inteligencii sa stanovuje jasný súbor pravidiel založených na riziku pre vývojárov a nasadzujúce subjekty umelej inteligencie, pokiaľ ide o konkrétne použitia umelej inteligencie. Akt o umelej inteligencii je súčasťou širšieho balíka politických opatrení na podporu rozvoja dôveryhodnej umelej inteligencie, ktorý zahŕňa aj inovačný balík v oblasti umelej inteligencie, spustenie tovární na umelú inteligenciu a koordinovaný plán v oblasti umelej inteligencie. Tieto opatrenia spoločne zaručujú bezpečnosť, základné práva a umelú inteligenciu sústredenú na človeka a posilňujú zavádzanie, investície a inovácie v oblasti umelej inteligencie v celej EÚ.

S cieľom uľahčiť prechod na nový regulačný rámec Komisia spustila pakt o umelej inteligencii, dobrovoľnú iniciatívu, ktorej cieľom je podporiť budúce vykonávanie, spolupracovať so zainteresovanými stranami a vyzvať poskytovateľov umelej inteligencie a nasadzujúce subjekty z Európy a mimo nej, aby včas splnili kľúčové povinnosti vyplývajúce z aktu o umelej inteligencii.

Prečo potrebujeme pravidlá o umelej inteligencii?

Akt o umelej inteligencii zabezpečuje, aby Európania mohli dôverovať tomu, čo umelá inteligencia ponúka. Zatiaľ čo väčšina systémov umelej inteligencie predstavuje obmedzené riziko a môže prispieť k riešeniu mnohých spoločenských výziev, niektoré systémy umelej inteligencie vytvárajú riziká, ktoré musíme riešiť, aby sme sa vyhli nežiaducim výsledkom.

Často napríklad nie je možné zistiť, prečo systém umelej inteligencie prijal rozhodnutie alebo predpoveď a prijal konkrétne opatrenie. Preto môže byť ťažké posúdiť, či niekto nebol nespravodlivo znevýhodnený, napríklad v rozhodnutí o prijatí do zamestnania alebo v žiadosti o verejnoprospešný systém.

Hoci existujúce právne predpisy poskytujú určitú ochranu, nepostačujú na riešenie konkrétnych výziev, ktoré môžu systémy umelej inteligencie priniesť.

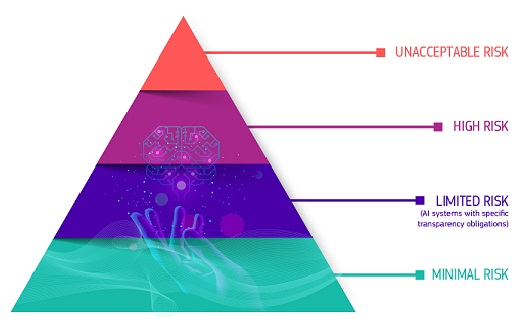

Prístup založený na riziku

V akte o umelej inteligencii sa vymedzujú štyri úrovne rizika pre systémy umelej inteligencie:

Neprijateľné riziko

Všetky systémy umelej inteligencie, ktoré sa považujú za jasnú hrozbu pre bezpečnosť, živobytie a práva ľudí, sú zakázané. V akte o umelej inteligencii sa zakazuje osem praktík, konkrétne:

- škodlivá manipulácia a klamanie založené na umelej inteligencii

- škodlivé využívanie zraniteľností založené na umelej inteligencii

- sociálne hodnotenie

- Posúdenie alebo prognóza rizika jednotlivých trestných činov

- necielené škrabanie internetového alebo CCTV materiálu s cieľom vytvoriť alebo rozšíriť databázy na rozpoznávanie tváre

- rozpoznávanie emócií na pracoviskách a vo vzdelávacích inštitúciách

- biometrická kategorizácia na odvodenie určitých chránených vlastností

- diaľková biometrická identifikácia v reálnom čase na účely presadzovania práva vo verejne prístupných priestoroch

Vysoké riziko

Prípady použitia umelej inteligencie, ktoré môžu predstavovať vážne riziká pre zdravie, bezpečnosť alebo základné práva, sa klasifikujú ako vysokorizikové. Tieto vysokorizikové prípady použitia zahŕňajú:

- Bezpečnostné komponenty umelej inteligencie v kritických infraštruktúrach (napr. v doprave), ktorých zlyhanie by mohlo ohroziť život a zdravie občanov

- Riešenia umelej inteligencie používané vo vzdelávacích inštitúciách, ktoré môžu určovať prístup k vzdelávaniu a priebehu pracovného života (napr. bodovanie skúšok)

- Bezpečnostné komponenty výrobkov založené na umelej inteligencii (napr. aplikácia umelej inteligencie v chirurgii s pomocou robota)

- Nástroje umelej inteligencie na zamestnávanie, riadenie pracovníkov a prístup k samostatnej zárobkovej činnosti (napr. softvér na triedenie životopisov na účely náboru)

- Určité prípady použitia umelej inteligencie využívané na poskytnutie prístupu k základným súkromným a verejným službám (napr. bodové hodnotenie kreditného rizika, ktorým sa občanom odopiera možnosť získať úver)

- systémy umelej inteligencie používané na diaľkovú biometrickú identifikáciu, rozpoznávanie emócií a biometrickú kategorizáciu (napr. systém umelej inteligencie na spätnú identifikáciu zlodeja v obchode),

- Prípady použitia umelej inteligencie pri presadzovaní práva, ktoré môžu zasahovať do základných práv ľudí (napr. hodnotenie spoľahlivosti dôkazov)

- Prípady použitia umelej inteligencie v oblasti migrácie, azylu a riadenia kontroly hraníc (napr. automatizované posudzovanie žiadostí o víza)

- Riešenia umelej inteligencie používané pri výkone spravodlivosti a demokratických procesoch (napr. riešenia umelej inteligencie na prípravu súdnych rozhodnutí)

Vysokorizikové systémy umelej inteligencie podliehajú pred uvedením na trh prísnym povinnostiam:

- primerané systémy posudzovania a zmierňovania rizika

- vysoká kvalita súborov údajov, ktorými sa systém zásobuje, s cieľom minimalizovať riziká diskriminačných výsledkov

- zaznamenávanie činnosti s cieľom zabezpečiť vysledovateľnosť výsledkov

- podrobnú dokumentáciu poskytujúcu všetky potrebné informácie o systéme a jeho účele, aby orgány mohli posúdiť jeho súlad

- jasné a primerané informácie pre nasadzujúci subjekt

- primerané opatrenia v oblasti ľudského dohľadu

- vysoká úroveň spoľahlivosti, kybernetickej bezpečnosti a presnosti

Riziko týkajúce sa transparentnosti

Týka sa to rizík spojených s potrebou transparentnosti v súvislosti s používaním umelej inteligencie. Aktom o umelej inteligencii sa zavádzajú osobitné povinnosti zverejňovania s cieľom zabezpečiť, aby boli ľudia v prípade potreby informovaní v záujme zachovania dôvery. Napríklad pri používaní systémov umelej inteligencie, ako sú chatboty, by ľudia mali byť informovaní o tom, že komunikujú so strojom, aby mohli prijať informované rozhodnutie.

Poskytovatelia generatívnej umelej inteligencie musia okrem toho zabezpečiť, aby bol obsah vytvorený umelou inteligenciou identifikovateľný. Okrem toho by mal byť určitý obsah vytvorený umelou inteligenciou jasne a viditeľne označený, konkrétne deepfake a text uverejnený s cieľom informovať verejnosť o záležitostiach verejného záujmu.

Minimálne alebo žiadne riziko

V akte o umelej inteligencii sa nezavádzajú pravidlá pre umelú inteligenciu, ktorá sa považuje za minimálne alebo žiadne riziko. Do tejto kategórie patrí prevažná väčšina systémov umelej inteligencie, ktoré sa v súčasnosti používajú v EÚ. Patria sem aplikácie, ako sú videohry s podporou umelej inteligencie alebo spamové filtre.

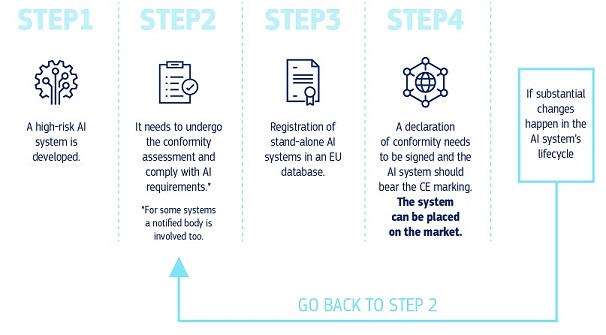

Ako to všetko funguje v praxi pre poskytovateľov vysokorizikových systémov umelej inteligencie?

Ako to všetko funguje v praxi pre poskytovateľov vysokorizikových systémov umelej inteligencie?

Ako to všetko funguje v praxi pre poskytovateľov vysokorizikových systémov umelej inteligencie?

Keď je systém umelej inteligencie na trhu, orgány sú zodpovedné za dohľad nad trhom, nasadzujúce subjekty zabezpečujú ľudský dohľad a monitorovanie a poskytovatelia majú zavedený systém monitorovania po uvedení na trh. Poskytovatelia a nasadzujúce subjekty budú nahlasovať aj závažné incidenty a poruchy.

Riešenie pre dôveryhodné používanie veľkých modelov umelej inteligencie

Modely umelej inteligencie na všeobecné účely môžu vykonávať širokú škálu úloh a stávajú sa základom mnohých systémov umelej inteligencie v EÚ. Niektoré z týchto modelov by mohli predstavovať systémové riziká, ak sú veľmi schopné alebo sa vo veľkej miere používajú. S cieľom zaistiť bezpečnú a dôveryhodnú umelú inteligenciu sa v akte o umelej inteligencii zavádzajú pravidlá pre poskytovateľov takýchto modelov. To zahŕňa pravidlá týkajúce sa transparentnosti a autorských práv. V prípade modelov, ktoré môžu predstavovať systémové riziká, by poskytovatelia mali posúdiť a zmierniť tieto riziká.

Pravidlá aktu o umelej inteligencii týkajúce sa umelej inteligencie na všeobecné účely nadobudnú účinnosť v auguste 2025. Úrad pre umelú inteligenciu uľahčuje vypracovanie kódexu postupov s cieľom podrobne opísať tieto pravidlá. Kódex by mal predstavovať ústredný nástroj pre poskytovateľov na preukázanie súladu s aktom o umelej inteligencii, ktorý zahŕňa najmodernejšie postupy.

Riadenie a vykonávanie

Európsky úrad pre umelú inteligenciu zriadený vo februári 2024 v rámci Komisie dohliada na presadzovanie a vykonávanie aktu o umelej inteligencii v členských štátoch EÚ. Bude tiež zodpovedná za dohľad nad najvýkonnejšími modelmi umelej inteligencie, tzv. modelmi umelej inteligencie na všeobecné účely. Členské štáty EÚ dohliadajú na pravidlá pre systémy umelej inteligencie a majú zriadiť dozorné orgány do 2. augusta 2025.

Riadenie aktu o umelej inteligencii budú riadiť tri poradné orgány:

- Európskej rady pre umelú inteligenciu zloženej zo zástupcov členských štátov EÚ

- vedeckej pracovnej skupiny zloženej z nezávislých odborníkov v oblasti umelej inteligencie

- poradné fórum, ktoré zastupuje rôznorodý výber zainteresovaných strán, komerčných aj nekomerčných

Touto správou viacerých zainteresovaných strán sa zabezpečí vyvážený prístup k vykonávaniu aktu o umelej inteligencii.

Ďalšie kroky

Akt o umelej inteligencii nadobudol účinnosť 1. augusta 2024 a bude sa plne uplatňovať o dva roky neskôr, 2. augusta 2026, s určitými výnimkami:

- zákazy a povinnosti týkajúce sa gramotnosti v oblasti umelej inteligencie sa začali uplatňovať od 2. februára 2025

- pravidlá riadenia a povinnosti týkajúce sa modelov umelej inteligencie na všeobecné účely sa začnú uplatňovať 2. augusta 2025

- pravidlá pre vysokorizikové systémy umelej inteligencie zabudované do regulovaných výrobkov majú predĺžené prechodné obdobie do 2. augusta 2027

Najnovšie správy

Report / Study

- 23-09-2024EU study calls for strategic AI adoption to transform public sector services

- 05-04-2024AI pre verejné blaho: Výskumná aliancia EÚ – USA v oblasti umelej inteligencie pre verejné blaho

- 30-11-2023Potenciál Európy v Edge Computing: Podpora priemyselných inovácií prostredníctvom rozsiahlych pilotných projektov

Súvisiaci obsah

Širšia perspektíva