Akt w sprawie sztucznej inteligencji to pierwsze w historii ramy prawne dotyczące sztucznej inteligencji, które odnoszą się do zagrożeń związanych ze sztuczną inteligencją i umożliwiają Europie odgrywanie wiodącej roli na świecie.

Akt w sprawie sztucznej inteligencji (rozporządzenie (UE) 2024/1689 ustanawiające zharmonizowane przepisy dotyczące sztucznej inteligencji) stanowi pierwsze w historii kompleksowe ramy prawne dotyczące sztucznej inteligencji na świecie. Celem przepisów jest wspieranie godnej zaufania sztucznej inteligencji w Europie.

W akcie w sprawie sztucznej inteligencji określono jasny zestaw zasad opartych na analizie ryzyka dla twórców i podmiotów wdrażających sztuczną inteligencję w odniesieniu do konkretnych zastosowań sztucznej inteligencji. Akt w sprawie sztucznej inteligencji jest częścią szerszego pakietu środków z zakresu polityki mających na celu wspieranie rozwoju godnej zaufania sztucznej inteligencji, który obejmuje również pakiet dotyczący innowacji w zakresie sztucznej inteligencji, uruchomienie fabryk sztucznej inteligencji i skoordynowany plan w sprawie sztucznej inteligencji. Łącznie środki te gwarantują bezpieczeństwo, prawa podstawowe i sztuczną inteligencję ukierunkowaną na człowieka oraz wzmacniają absorpcję, inwestycje i innowacje w dziedzinie sztucznej inteligencji w całej UE.

Aby ułatwić przejście na nowe ramy regulacyjne, Komisja uruchomiła pakt na rzecz sztucznej inteligencji, dobrowolną inicjatywę mającą na celu wspieranie przyszłego wdrażania, współpracę z zainteresowanymi stronami oraz zaproszenie dostawców i podmiotów wdrażających sztuczną inteligencję z Europy i spoza niej do wywiązania się z kluczowych obowiązków określonych w akcie w sprawie sztucznej inteligencji z wyprzedzeniem.

Dlaczego potrzebujemy przepisów dotyczących sztucznej inteligencji?

Akt w sprawie sztucznej inteligencji gwarantuje, że Europejczycy mogą ufać temu, co sztuczna inteligencja ma do zaoferowania. Chociaż większość systemów sztucznej inteligencji nie stwarza żadnego ryzyka i może przyczynić się do rozwiązania wielu wyzwań społecznych, niektóre systemy sztucznej inteligencji stwarzają ryzyko, któremu musimy przeciwdziałać, aby uniknąć niepożądanych skutków.

Na przykład często nie można dowiedzieć się, dlaczego system sztucznej inteligencji podjął decyzję lub prognozę i podjął określone działanie. W związku z tym może być trudno ocenić, czy dana osoba znalazła się w niesprawiedliwie niekorzystnej sytuacji, na przykład w decyzji o zatrudnieniu lub we wniosku o program pożytku publicznego.

Chociaż obowiązujące przepisy zapewniają pewną ochronę, nie są one wystarczające, aby sprostać szczególnym wyzwaniom, jakie mogą wiązać się z systemami sztucznej inteligencji.

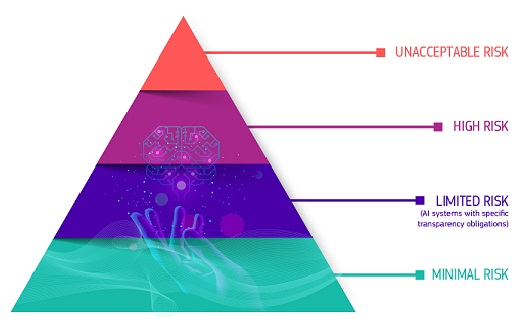

Podejście oparte na analizie ryzyka

W akcie w sprawie sztucznej inteligencji określono cztery poziomy ryzyka dla systemów sztucznej inteligencji:

Niedopuszczalne ryzyko

Wszystkie systemy sztucznej inteligencji uznawane za wyraźne zagrożenie dla bezpieczeństwa, źródeł utrzymania i praw ludzi są zakazane. Akt w sprawie sztucznej inteligencji zakazuje ośmiu praktyk, a mianowicie:

- szkodliwa manipulacja i oszustwo oparte na sztucznej inteligencji

- szkodliwe wykorzystywanie podatności w oparciu o sztuczną inteligencję

- punktacja społeczna

- Ocena lub przewidywanie ryzyka związanego z indywidualnym przestępstwem

- nieukierunkowane skrobanie materiałów internetowych lub CCTV w celu utworzenia lub rozszerzenia baz danych rozpoznawania twarzy

- Rozpoznawanie emocji w miejscach pracy i instytucjach edukacyjnych

- kategoryzacja biometryczna w celu wydedukowania niektórych cech chronionych

- zdalna identyfikacja biometryczna w czasie rzeczywistym na potrzeby ochrony porządku publicznego w przestrzeni publicznej

Wysokie ryzyko

Przypadki użycia sztucznej inteligencji, które mogą stwarzać poważne ryzyko dla zdrowia, bezpieczeństwa lub praw podstawowych, klasyfikuje się jako przypadki wysokiego ryzyka. Te przypadki użycia wysokiego ryzyka obejmują:

- Elementy bezpieczeństwa sztucznej inteligencji w infrastrukturze krytycznej (np. w transporcie), których awaria mogłaby zagrozić życiu i zdrowiu obywateli

- Rozwiązania AI stosowane w instytucjach edukacyjnych, które mogą decydować o dostępie do edukacji i przebiegu czyjegoś życia zawodowego (np. punktacja egzaminów)

- Elementy bezpieczeństwa produktów oparte na sztucznej inteligencji (np. zastosowanie sztucznej inteligencji w chirurgii wspomaganej robotem)

- Narzędzia sztucznej inteligencji do celów zatrudnienia, zarządzania pracownikami i dostępu do samozatrudnienia (np. oprogramowanie do sortowania CV do celów rekrutacji)

- Niektóre przypadki użycia sztucznej inteligencji wykorzystywane do zapewnienia dostępu do podstawowych usług prywatnych i publicznych (np. punktowa ocena kredytowa pozbawiająca obywateli możliwości uzyskania pożyczki)

- Systemy sztucznej inteligencji wykorzystywane do zdalnej identyfikacji biometrycznej, rozpoznawania emocji i kategoryzacji biometrycznej (np. system sztucznej inteligencji służący do retroaktywnej identyfikacji złodzieja sklepowego)

- Przypadki użycia sztucznej inteligencji w organach ścigania, które mogą kolidować z prawami podstawowymi ludzi (np. ocena wiarygodności dowodów)

- Przypadki użycia sztucznej inteligencji w zarządzaniu migracją, azylem i kontrolą graniczną (np. zautomatyzowane rozpatrywanie wniosków wizowych)

- Rozwiązania w zakresie sztucznej inteligencji wykorzystywane w wymiarze sprawiedliwości i procesach demokratycznych (np. rozwiązania w zakresie sztucznej inteligencji służące do przygotowywania orzeczeń sądowych)

Systemy sztucznej inteligencji wysokiego ryzyka podlegają rygorystycznym obowiązkom, zanim będą mogły zostać wprowadzone do obrotu:

- odpowiednie systemy oceny i ograniczania ryzyka

- wysokiej jakości zbiory danych zasilające system w celu zminimalizowania ryzyka dyskryminacyjnych wyników

- rejestrowanie działalności w celu zapewnienia identyfikowalności wyników

- szczegółową dokumentację zawierającą wszystkie informacje niezbędne organom do oceny zgodności systemu i jego celu;

- jasne i odpowiednie informacje dla podmiotu wdrażającego

- odpowiednie środki nadzoru ze strony człowieka

- wysoki poziom solidności, cyberbezpieczeństwa i dokładności

Ryzyko związane z przejrzystością

Odnosi się to do ryzyka związanego z potrzebą przejrzystości w zakresie stosowania sztucznej inteligencji. Akt w sprawie sztucznej inteligencji wprowadza szczególne obowiązki w zakresie ujawniania informacji w celu zapewnienia, aby ludzie byli informowani, gdy jest to konieczne do zachowania zaufania. Na przykład podczas korzystania z systemów sztucznej inteligencji, takich jak chatboty, ludzie powinni być świadomi, że wchodzą w interakcję z maszyną, aby mogli podjąć świadomą decyzję.

Ponadto dostawcy generatywnej sztucznej inteligencji muszą zapewnić identyfikowalność treści generowanych przez sztuczną inteligencję. Ponadto niektóre treści generowane przez sztuczną inteligencję powinny być wyraźnie i wyraźnie oznakowane, a mianowicie deepfake i tekst publikowany w celu informowania opinii publicznej o sprawach leżących w interesie publicznym.

Minimalne ryzyko lub brak ryzyka

Akt w sprawie sztucznej inteligencji nie wprowadza przepisów dotyczących sztucznej inteligencji, którą uznaje się za obarczoną minimalnym ryzykiem lub nieobjętą żadnym ryzykiem. Zdecydowana większość systemów sztucznej inteligencji stosowanych obecnie w UE należy do tej kategorii. Obejmuje to aplikacje takie jak gry wideo z obsługą sztucznej inteligencji lub filtry antyspamowe.

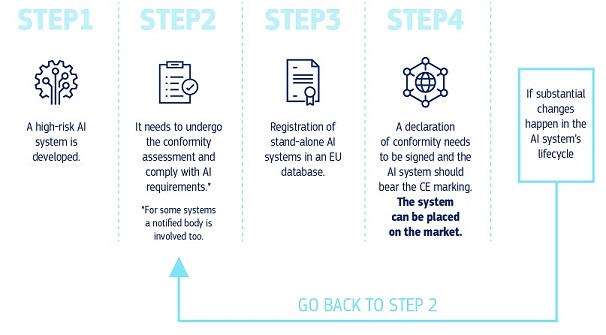

Jak to wszystko działa w praktyce w przypadku dostawców systemów sztucznej inteligencji wysokiego ryzyka?

Jak to wszystko działa w praktyce w przypadku dostawców systemów sztucznej inteligencji wysokiego ryzyka?

Po wprowadzeniu systemu sztucznej inteligencji do obrotu organy są odpowiedzialne za nadzór rynku, podmioty wdrażające zapewniają nadzór i monitorowanie przez człowieka, a dostawcy posiadają system monitorowania po wprowadzeniu do obrotu. Dostawcy i podmioty wdrażające będą również zgłaszać poważne incydenty i nieprawidłowe funkcjonowanie.

Rozwiązanie do godnego zaufania wykorzystania dużych modeli sztucznej inteligencji

Modele sztucznej inteligencji ogólnego przeznaczenia mogą wykonywać szeroki zakres zadań i stają się podstawą wielu systemów sztucznej inteligencji w UE. Niektóre z tych modeli mogą wiązać się z ryzykiem systemowym, jeśli są bardzo sprawne lub szeroko stosowane. Aby zapewnić bezpieczną i godną zaufania sztuczną inteligencję, w akcie w sprawie sztucznej inteligencji wprowadzono przepisy dotyczące dostawców takich modeli. Obejmuje to przejrzystość i przepisy dotyczące praw autorskich. W przypadku modeli, które mogą wiązać się z ryzykiem systemowym, dostawcy powinni ocenić i ograniczyć to ryzyko.

Przepisy aktu w sprawie sztucznej inteligencji dotyczące sztucznej inteligencji ogólnego przeznaczenia wejdą w życie w sierpniu 2025 r. Urząd ds. Sztucznej Inteligencji ułatwia opracowanie kodeksu postępowania w celu uszczegółowienia tych przepisów. Kodeks powinien stanowić dla dostawców centralne narzędzie do wykazania zgodności z aktem w sprawie sztucznej inteligencji, obejmujące najnowocześniejsze praktyki.

Zarządzanie i wdrażanie

Europejski Urząd ds. Sztucznej Inteligencji i organy państw członkowskich są odpowiedzialne za wdrażanie, nadzorowanie i egzekwowanie aktu w sprawie sztucznej inteligencji. Rada ds. Sztucznej Inteligencji, panel naukowy i forum doradcze kierują zarządzaniem aktem w sprawie sztucznej inteligencji i doradzają w tym zakresie. Więcej informacji na temat zarządzania aktem w sprawie sztucznej inteligencji i jego egzekwowania.

Kolejne kroki

Akt w sprawie sztucznej inteligencji wszedł w życie 1 sierpnia 2024 r. i będzie w pełni stosowany 2 lata później 2 sierpnia 2026 r., z pewnymi wyjątkami:

- zakazy i obowiązki w zakresie umiejętności korzystania ze sztucznej inteligencji weszły w życie z dniem 2 lutego 2025 r.

- zasady zarządzania i obowiązki dotyczące modeli sztucznej inteligencji ogólnego przeznaczenia zaczną obowiązywać w dniu 2 sierpnia 2025 r.

- przepisy dotyczące systemów sztucznej inteligencji wysokiego ryzyka – wbudowanych w produkty regulowane – mają przedłużony okres przejściowy do 2 sierpnia 2027 r.

Najnowsze wiadomości

Polityka i prawodawstwo

- 11-03-2025Trzeci projekt ogólnego kodeksu postępowania w zakresie sztucznej inteligencji opublikowany przez niezależnych ekspertów

- 11-03-2025Komisja przyjmuje akt wykonawczy w celu ustanowienia panelu naukowego na podstawie aktu w sprawie sztucznej inteligencji

- 28-02-2025Drugie posiedzenie Rady UE–Indie ds. Handlu i Technologii – wspólne oświadczenie

Sprawozdanie/badanie

- 23-09-2024EU study calls for strategic AI adoption to transform public sector services

- 05-04-2024AI dla dobra publicznego: Sojusz UE-USA w dziedzinie AI na rzecz dobra publicznego

- 30-11-2023Potencjał Europy w dziedzinie obliczeń ewidencyjnych: Wspieranie innowacji przemysłowych poprzez projekty pilotażowe na dużą skalę

Zestawienie informacji / infografika

Broszura

- 04-02-2025Żywe repozytorium wspierające uczenie się i wymianę informacji na temat umiejętności korzystania ze sztucznej inteligencji

- 04-03-2024Program „Horyzont Europa”: nowe projekty w dziedzinie sztucznej inteligencji, danych i robotyki – 2024 Edition

- 14-04-2021Nowe projekty robotyki w ramach programu „Horyzont 2020” na 2021 r.

Podobne tematy

W szerszej perspektywie

Szczegółowe wyjaśnienia

-

Europejski Urząd ds. Sztucznej Inteligencji i krajowe organy nadzoru rynku są odpowiedzialne za...