La législation sur l’IA est le tout premier cadre juridique sur l’IA, qui traite des risques liés à l’IA et positionne l’Europe à jouer un rôle de premier plan au niveau mondial.

Le règlement sur l’IA [règlement (UE) 2024/1689 établissant des règles harmonisées en matière d’intelligence artificielle] est le tout premier cadre juridique complet sur l’IA dans le monde. L’objectif de ces règles est de favoriser une IA digne de confiance en Europe.

La législation sur l’IA établit un ensemble clair de règles fondées sur les risques pour les développeurs et les déployeurs d’IA en ce qui concerne les utilisations spécifiques de l’IA. La législation sur l’IA fait partie d’un ensemble plus large de mesures visant à soutenir le développement d’une IA digne de confiance, qui comprend également le train de mesures sur l’innovation dans le domaine de l’IA, le lancement d’usines d’IA et le plan coordonné en matière d’IA. Ensemble, ces mesures garantissent la sécurité, les droits fondamentaux et l’IA centrée sur l’humain, et renforcent l’adoption, l’investissement et l’innovation dans l’IA dans l’ensemble de l’UE.

Afin de faciliter la transition vers le nouveau cadre réglementaire, la Commission a lancé le pacte sur l’IA, une initiative volontaire qui vise à soutenir la mise en œuvre future, à nouer le dialogue avec les parties prenantes et à inviter les fournisseurs et les déployeurs d’IA d’Europe et d’ailleurs à se conformer à l’avance aux principales obligations de la législation sur l’IA.

Pourquoi avons-nous besoin de règles sur l’IA?

La législation sur l’IA garantit que les Européens peuvent faire confiance à ce que l’IA a à offrir. Alors que la plupart des systèmes d’IA présentent un risque limité voire nul et peuvent contribuer à résoudre de nombreux défis sociétaux, certains systèmes d’IA créent des risques auxquels nous devons faire face pour éviter des résultats indésirables.

Par exemple, il est souvent impossible de savoir pourquoi un système d'IA a pris une décision ou une prédiction et a pris une mesure particulière. Il peut donc devenir difficile d'évaluer si une personne a été injustement désavantagée, par exemple dans une décision d'embauche ou dans une demande de régime d'utilité publique.

Bien que la législation existante offre une certaine protection, elle est insuffisante pour relever les défis spécifiques que les systèmes d’IA peuvent poser.

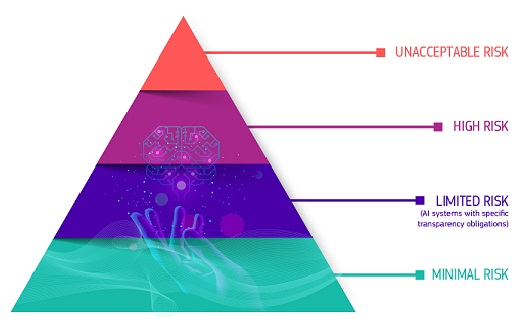

Une approche fondée sur les risques

La législation sur l’IA définit quatre niveaux de risque pour les systèmes d’IA:

Risque inacceptable

Tous les systèmes d'IA considérés comme une menace évidente pour la sécurité, les moyens de subsistance et les droits des personnes sont interdits. La législation sur l’IA interdit huit pratiques, à savoir:

- manipulation et tromperie préjudiciables fondées sur l’IA

- exploitation préjudiciable des vulnérabilités fondée sur l’IA

- notation sociale

- Évaluation ou prédiction du risque d’infraction pénale individuelle

- raclage non ciblé de matériel internet ou de vidéosurveillance pour créer ou développer des bases de données de reconnaissance faciale

- Reconnaissance des émotions sur les lieux de travail et dans les établissements d'enseignement

- catégorisation biométrique pour déduire certaines caractéristiques protégées

- identification biométrique à distance en temps réel à des fins répressives dans des espaces accessibles au public

Risque élevé

Les cas d’utilisation de l’IA susceptibles de présenter des risques graves pour la santé, la sécurité ou les droits fondamentaux sont classés comme étant à haut risque. Ces cas d'utilisation à haut risque comprennent:

- Composants de sécurité de l’IA dans les infrastructures critiques (par exemple, les transports), dont la défaillance pourrait mettre en danger la vie et la santé des citoyens

- Solutions d’IA utilisées dans les établissements d’enseignement, qui peuvent déterminer l’accès à l’éducation et le déroulement de la vie professionnelle d’une personne (par exemple, notation des examens)

- Composants de sécurité des produits basés sur l’IA (par exemple, application de l’IA en chirurgie assistée par robot)

- Outils d’IA pour l’emploi, la gestion des travailleurs et l’accès au travail indépendant (par exemple, logiciel de tri de CV pour le recrutement)

- Certains cas d’utilisation de l’IA utilisés pour donner accès à des services publics et privés essentiels (par exemple, l’évaluation du crédit privant les citoyens de la possibilité d’obtenir un prêt)

- Systèmes d’IA utilisés pour l’identification biométrique à distance, la reconnaissance des émotions et la catégorisation biométrique (par exemple, système d’IA permettant d’identifier rétroactivement un voleur à l’étalage)

- Cas d’utilisation de l’IA dans les services répressifs susceptibles d’interférer avec les droits fondamentaux des personnes (par exemple, évaluation de la fiabilité des preuves)

- Cas d’utilisation de l’IA dans la gestion des migrations, de l’asile et des contrôles aux frontières (par exemple, examen automatisé des demandes de visa)

- Solutions d’IA utilisées dans l’administration de la justice et les processus démocratiques (par exemple, solutions d’IA pour préparer les décisions de justice)

Les systèmes d’IA à haut risque sont soumis à des obligations strictes avant de pouvoir être mis sur le marché:

- des systèmes adéquats d'évaluation et d'atténuation des risques;

- haute qualité des ensembles de données alimentant le système afin de réduire au minimum les risques de résultats discriminatoires

- journalisation de l'activité pour assurer la traçabilité des résultats

- une documentation détaillée fournissant toutes les informations nécessaires sur le système et sa finalité pour permettre aux autorités d’évaluer sa conformité;

- information claire et adéquate du déployeur

- mesures appropriées de contrôle humain

- haut niveau de robustesse, de cybersécurité et de précision

Risque de transparence

Il s’agit des risques associés à un besoin de transparence concernant l’utilisation de l’IA. La législation sur l’IA introduit des obligations de divulgation spécifiques pour veiller à ce que les êtres humains soient informés lorsque cela est nécessaire pour préserver la confiance. Par exemple, lors de l'utilisation de systèmes d'IA tels que les chatbots, les humains doivent être informés qu'ils interagissent avec une machine afin de pouvoir prendre une décision éclairée.

En outre, les fournisseurs d’IA générative doivent veiller à ce que le contenu généré par l’IA soit identifiable. En outre, certains contenus générés par l’IA devraient être clairement et visiblement étiquetés, à savoir les deep fakes et les textes publiés dans le but d’informer le public sur des questions d’intérêt public.

Risque minimal ou nul

La législation sur l’IA n’introduit pas de règles pour l’IA considérées comme présentant un risque minimal ou nul. La grande majorité des systèmes d’IA actuellement utilisés dans l’UE entrent dans cette catégorie. Cela inclut des applications telles que les jeux vidéo compatibles avec l'IA ou les filtres anti-spam.

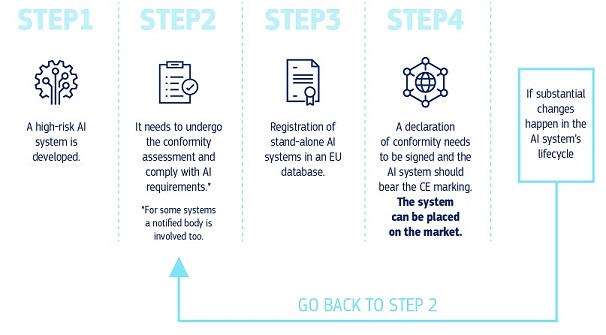

Comment tout cela fonctionne-t-il dans la pratique pour les fournisseurs de systèmes d’IA à haut risque?

Comment tout cela fonctionne-t-il dans la pratique pour les fournisseurs de systèmes d’IA à haut risque?

Une fois qu’un système d’IA est sur le marché, les autorités sont chargées de la surveillance du marché, les déployeurs assurent la surveillance et le suivi humains et les fournisseurs disposent d’un système de surveillance après commercialisation. Les fournisseurs et les déployeurs signaleront également les incidents graves et les dysfonctionnements.

Une solution pour une utilisation fiable des grands modèles d'IA

Les modèles d’IA à usage général peuvent effectuer un large éventail de tâches et deviennent la base de nombreux systèmes d’IA dans l’UE. Certains de ces modèles pourraient comporter des risques systémiques s'ils sont très performants ou largement utilisés. Afin de garantir une IA sûre et digne de confiance, la législation sur l’IA met en place des règles pour les fournisseurs de ces modèles. Il s'agit notamment des règles relatives à la transparence et au droit d'auteur. Pour les modèles susceptibles de comporter des risques systémiques, les fournisseurs devraient évaluer et atténuer ces risques.

Les règles de la législation sur l’IA relatives à l’IA à usage général entreront en vigueur en août 2025. Le Bureau de l’IA facilite l’élaboration d’un code de bonnes pratiques pour détailler ces règles. Le code devrait constituer un outil central permettant aux fournisseurs de démontrer leur conformité avec la législation sur l’IA, en intégrant des pratiques de pointe.

Gouvernance et mise en œuvre

Le Bureau européen de l’IA et les autorités des États membres sont responsables de la mise en œuvre, de la surveillance et de l’application de la législation sur l’IA. Le comité de l’IA, le groupe scientifique et le forum consultatif orientent et conseillent la gouvernance de la législation sur l’IA. En savoir plus sur la gouvernance et l’application de la législation sur l’IA.

Prochaines étapes

La législation sur l’IA est entrée en vigueur le 1er août 2024 et sera pleinement applicable deux ans plus tard, le 2 août 2026, à quelques exceptions près:

- interdictions et obligations en matière d’éducation à l’IA entrées en application le 2 février 2025

- les règles de gouvernance et les obligations relatives aux modèles d’IA à usage général deviennent applicables le 2 août 2025.

- les règles applicables aux systèmes d’IA à haut risque – intégrés dans des produits réglementés – bénéficient d’une période de transition prolongée jusqu’au 2 août 2027.

Dernières nouvelles

Politique et législation

- 11-03-2025Publication du troisième projet de code de bonnes pratiques sur l’IA à usage général, rédigé par des experts indépendants

- 11-03-2025La Commission adopte un acte d’exécution pour créer un groupe scientifique au titre de la législation sur l’IA

- 28-02-2025Deuxième réunion du Conseil du commerce et des technologies Inde-UE - Déclaration conjointe

Rapport / Etude

- 23-09-2024EU study calls for strategic AI adoption to transform public sector services

- 05-04-2024L’IA pour le bien public: Alliance de recherche UE-États-Unis sur l’IA pour le bien public

- 30-11-2023Le potentiel de l’Europe en Edge Computing: Soutenir l’innovation industrielle au moyen de projets pilotes à grande échelle

Fiche d’information / infographie

- 05-04-2024Fiche d’information: Conseil du commerce et de la technologie UE-États-Unis (2021-2024)

- 21-02-2024Fiche d’information sur le paquet «Connectivité» sur les réseaux et infrastructures numériques

- 31-05-2023Conseil du commerce et des technologies UE-États-Unis — Quatrième réunion ministérielle — Résultats clés

Contenu associé

Vue d’ensemble

Aller plus loin

-

Le Bureau européen de l’IA et les autorités nationales de surveillance du marché sont responsables...