Законодателният акт за ИИ е първата по рода си правна рамка за ИИ, която разглежда рисковете от ИИ и поставя Европа да играе водеща роля в световен мащаб.

Законът заИИ (Регламент (ЕС) 2024/1689 за определяне на хармонизирани правила относно изкуствения интелект)предоставя на разработчиците и внедрителите на ИИ ясни изисквания и задължения по отношение на специфичните употреби на ИИ. В същото време регламентът има за цел да намали административната и финансовата тежест за предприятията, по-специално за малките и средните предприятия (МСП).

Законодателният акт за ИИ е част от по-широк пакет от мерки на политиката в подкрепа на разработването на надежден ИИ, който включва също пакета за иновации в областта на ИИ икоординирания план за ИИ. Взети заедно, тези мерки гарантират безопасността и основните права на хората и предприятията, когато става въпрос за ИИ. Те също така засилват навлизането, инвестициите и иновациите в областта на ИИ в целия ЕС.

Законът заИИ е първата по рода си всеобхватна правна рамка за ИИ в световен мащаб. Целта на новите правила е да се насърчи надежден ИИ в Европа и извън нея, като се гарантира, че системите с ИИ зачитат основните права, безопасността и етичните принципи, и като се обърне внимание на рисковете от много мощни и въздействащи модели на ИИ.

Защо са ни необходими правила за ИИ?

Законът за ИИ гарантира, че европейците могат да се доверят на това, което ИИ може да предложи. Въпреки че повечето системи с ИИ представляват ограничен риск и могат да допринесат за решаването на много обществени предизвикателства, някои системи с ИИ създават рискове, с които трябва да се справим, за да избегнем нежелани резултати.

Например често не е възможно да се разбере защо дадена система с ИИ е взела решение или прогноза и е предприела конкретно действие. Така че може да се окаже трудно да се прецени дали дадено лице е било несправедливо в неравностойно положение, като например при решение за наемане на работа или в заявление за схема за обществена полза.

Въпреки че съществуващото законодателство осигурява известна защита, то не е достатъчно за справяне със специфичните предизвикателства, които могат да доведат системите с ИИ.

Новите правила:

- справяне с рисковете, създадени специално от приложенията с ИИ

- забрана на практики с ИИ, които представляват неприемливи рискове

- определяне на списък с високорискови приложения

- определяне на ясни изисквания за системите с ИИ за високорискови приложения

- определяне на конкретни задължения за внедрителите и доставчиците на високорискови приложения с ИИ

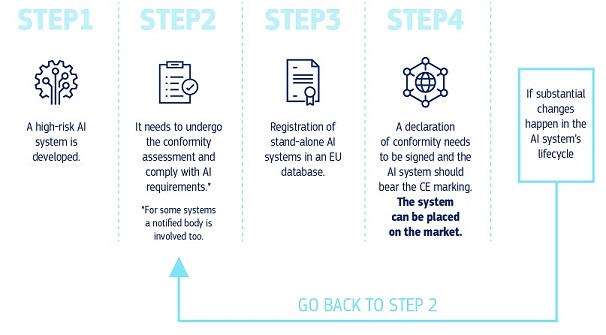

- изискване за оценяване на съответствието преди дадена система с ИИ да бъде въведена в експлоатация или пусната на пазара

- въвеждане на правоприлагане след пускането на дадена система с ИИ на пазара

- създаване на управленска структура на европейско и национално равнище

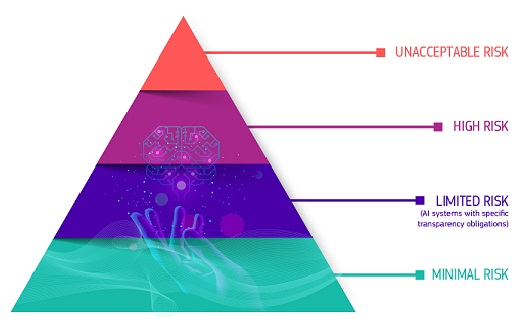

Подход, основан на риска

Регулаторната рамка определя 4 нива на риск за системите с ИИ:

Всички системи с ИИ, считани за ясна заплаха за безопасността, поминъка и правата на хората, са забранени — от социалното оценяване от страна на правителствата до играчките, използващи гласова помощ, която насърчава опасно поведение.

Висок риск

Системите с ИИ, определени като високорискови, включват технологията с ИИ, използвана в:

- критични инфраструктури (напр. транспорт), които биха могли да изложат на риск живота и здравето на гражданите

- образование или професионално обучение, което може да определи достъпа до образование и професионален курс на нечий живот (напр. оценяване на изпитите)

- компоненти за безопасност на продуктите (напр. приложение с ИИ при операции, подпомагани от роботи)

- заетост, управление на работниците и достъп до самостоятелна заетост (напр. софтуер за сортиране на автобиографии за процедури за набиране на персонал)

- основни частни и обществени услуги (напр. кредитна оценка, която лишава гражданите от възможността да получат заем)

- правоприлагане, което може да наруши основните права на хората (напр. оценка на надеждността на доказателствата)

- управление на миграцията, убежището и граничния контрол (напр. автоматизирано разглеждане на заявленията за издаване на визи)

- правораздаване и демократични процеси (напр. решения с ИИ за търсене на съдебни решения)

Високорисковите системи с ИИ подлежат на строги задължения, преди да могат да бъдат пуснати на пазара:

- адекватни системи за оценка и намаляване на риска

- високо качество на наборите от данни, захранващи системата, за да се сведат до минимум рисковете и дискриминационните резултати

- регистриране на дейността, за да се гарантира проследимостта на резултатите

- подробна документация, предоставяща цялата необходима информация за системата и нейната цел, за да могат органите да оценят нейното съответствие

- ясна и адекватна информация за внедрителя

- подходящи човешки надзорни мерки за свеждане до минимум на риска

- високо ниво на устойчивост, сигурност и точност

Всички системи за дистанционна биометрична идентификация се считат за високорискови и подлежат на строги изисквания. Използването на дистанционна биометрична идентификация на публично достъпни места за целите на правоприлагането по принцип е забранено.

Строго определени и регулирани са тесните изключения, като например, когато е необходимо, за издирване на изчезнало дете, за предотвратяване на конкретна и непосредствена терористична заплаха или за разкриване, локализиране, идентифициране или наказателно преследване на извършител или заподозрян в тежко престъпление.

Тези употреби подлежат на разрешение от съдебен или друг независим орган и на подходящи ограничения във времето, географския обхват и търсените бази данни.

Ограничен риск

Ограниченият риск есвързан с рисковете, свързани с липсата на прозрачност при използването на ИИ. Със Закона за ИИ се въвеждат специфични задължения за прозрачност, за да се гарантира, че хората са информирани, когато е необходимо, като се насърчава доверието. Например, когато използват системи с ИИ, като например чатботове, хората следва да бъдат информирани, че взаимодействат с машина, за да могат да вземат информирано решение да продължат или да се отдръпнат. Доставчиците трябва също така да гарантират, че генерираното от ИИ съдържание може да бъде идентифицирано. Освен това текстът, генериран от ИИ, публикуван с цел информиране на обществеността по въпроси от обществен интерес, трябва да бъде обозначен като изкуствено генериран. Това важи и за аудио и видео съдържание, което представлява дълбоки фалшификати.

Минимален или никакъв риск

Законът за ИИ позволява безплатното използване на ИИ с минимален риск. Това включва приложения като видеоигри с изкуствен интелект или спам филтри. По-голямата част от системите с ИИ, които понастоящем се използват в ЕС, попадат в тази категория.

Как работи всичко това на практика за доставчиците на високорискови системи с ИИ?

След като дадена система с ИИ бъде пусната на пазара, органите отговарят за надзора на пазара, внедрителите осигуряват човешки надзор и мониторинг, а доставчиците разполагат със система за наблюдение след пускането на пазара. Доставчиците и внедрителите също ще докладват за сериозни инциденти и неизправности.

Решение за надеждно използване на големи модели с ИИ

Все повече и повече моделите на ИИ с общо предназначение се превръщат в компоненти на системите с ИИ. Тези модели могат да изпълняват и адаптират безброй различни задачи.

Въпреки че моделите на ИИ с общо предназначение могат да дадат възможност за по-добри и по-мощни решения с ИИ, е трудно да се контролират всички възможности.

Там Законодателният акт за ИИ въвежда задължения за прозрачност за всички модели с общо предназначение, за да се даде възможност за по-добро разбиране на тези модели и допълнителни задължения за управление на риска за много способни и въздействащи модели. Тези допълнителни задължения включват самооценка и смекчаване на системните рискове, докладване на сериозни инциденти, провеждане на оценки на изпитвания и модели, както и изисквания за киберсигурност.

Законодателство, съобразено с бъдещето

Тъй като ИИ е бързо развиваща се технология, регламентът има ориентиран към бъдещето подход, който позволява на правилата да се адаптират към технологичните промени. Приложенията с ИИ следва да останат надеждни дори и след пускането им на пазара. Това изисква непрекъснато управление на качеството и риска от страна на доставчиците.

Правоприлагане и изпълнение

Европейската служба за ИИ, създадена през февруари 2024 г. в рамките на Комисията, наблюдава прилагането и прилагането на Закона за ИИ заедно с държавите членки. Тя има за цел да създаде среда, в която технологиите за ИИ зачитат човешкото достойнство, права и доверие. Той също така насърчава сътрудничеството, иновациите и научните изследвания в областта на ИИ между различните заинтересовани страни. Освен това тя участва в международен диалог и сътрудничество по въпроси, свързани с ИИ, като признава необходимостта от привеждане в съответствие в световен мащаб на управлението на ИИ. Чрез тези усилия Европейската служба за ИИ се стреми да позиционира Европа като лидер в етичното и устойчиво развитие на технологиите в областта на ИИ.

Следващи стъпки

Законът заИИ влезе в сила на 1 август и ще се прилага изцяло 2 години по-късно, с някои изключения: забраните ще влязат в сила след шест месеца, правилата за управление и задълженията за моделите на ИИ с общо предназначение ще започнат да се прилагат след 12 месеца, а правилата за системите с ИИ — вградени в регулирани продукти — ще се прилагат след 36 месеца. За да се улесни преходът към новата регулаторна рамка, Комисията стартирапакта за ИИ—доброволна инициатива, която има за цел да подкрепи бъдещото прилагане и приканва разработчиците на ИИ от Европа и извън нея предварително да изпълнят основните задължения на Акта за ИИ.

Последни новини

Report / Study

- 23-09-2024EU study calls for strategic AI adoption to transform public sector services

- 05-04-2024ИИ за обществено благо: Научноизследователски алианс между ЕС и САЩ в областта на ИИ за обществено благо

- 30-11-2023Потенциалът на Европа в областта на периферните изчисления: Подкрепа за промишлените иновации чрез широкомащабни пилотни проекти

Съдържание по темата

Обща картина

Подходът на ЕС към изкуствения интелект се основава на високи постижения и доверие, като целта е да се стимулират научните изследвания и промишленият капацитет, като същевременно се гарантират безопасността и основните права.

По-задълбочено

Пактът за ИИ насърчава и подкрепя организациите да планират предварително прилагането на мерките по Законодателния акт за ИИ.

Вижте също

Първият Кодекс за поведение в областта на ИИ с общо предназначение ще съдържа подробно описание на правилата на Закона за ИИ за доставчиците на модели на ИИ с общо предназначение и модели на ИИ с общо предназначение със системни рискове.

Международната инициатива за ориентиран към човека изкуствен интелект ще спомогне за популяризирането на визията на ЕС за устойчив и надежден ИИ.

Координираният план за изкуствения интелект има за цел да ускори инвестициите в ИИ, да приложи стратегии и програми в областта на ИИ и да съгласува политиката в областта на ИИ, за да се предотврати разпокъсаността в Европа.

Европейската комисия назначи експертна група, която да предоставя съвети относно своята стратегия за изкуствен интелект.

Европейският алианс за ИИ е инициатива на Европейската комисия за установяване на открит политически диалог в областта на изкуствения интелект. От стартирането си през 2018 г. Алиансът за ИИ е ангажирал около 6000 заинтересовани страни чрез редовни прояви, обществени консултации...