La Ley de IA es el primer marco jurídico sobre IA, que aborda los riesgos de la IA y posiciona a Europa para desempeñar un papel de liderazgo a nivel mundial.

La Ley de IA [Reglamento (UE) 2024/1689 por el que se establecen normas armonizadas sobre inteligencia artificial] es el primer marco jurídico exhaustivo sobre IA en todo el mundo. El objetivo de las normas es fomentar una IA fiable en Europa.

La Ley de IA establece un conjunto claro de normas basadas en el riesgo para los desarrolladores y los implementadores de IA en relación con los usos específicos de la IA. La Ley de IA forma parte de un paquete más amplio de medidas políticas para apoyar el desarrollo de una IA fiable, que también incluye el paquete de innovación en materia de IA, la puesta en marcha de fábricas de IA y el plan coordinado sobre IA. En conjunto, estas medidas garantizan la seguridad, los derechos fundamentales y la IA centrada en el ser humano, y refuerzan la adopción, la inversión y la innovación en IA en toda la UE.

Para facilitar la transición al nuevo marco regulador, la Comisión ha puesto en marcha el Pacto sobre la IA, una iniciativa voluntaria que pretende apoyar la futura aplicación, colaborar con las partes interesadas e invitar a los proveedores e implementadores de IA de Europa y de fuera de ella a cumplir con antelación las obligaciones clave de la Ley de IA.

¿Por qué necesitamos normas sobre la IA?

La Ley de IA garantiza que los europeos puedan confiar en lo que la IA tiene para ofrecer. Si bien la mayoría de los sistemas de IA presentan un riesgo limitado o nulo y pueden contribuir a resolver muchos retos sociales, determinados sistemas de IA crean riesgos que debemos abordar para evitar resultados indeseables.

Por ejemplo, a menudo no es posible averiguar por qué un sistema de IA ha tomado una decisión o predicción y ha tomado una acción en particular. Por lo tanto, puede ser difícil evaluar si alguien ha sido injustamente desfavorecido, como en una decisión de contratación o en una solicitud de un plan de beneficios públicos.

Aunque la legislación vigente ofrece cierta protección, es insuficiente para abordar los retos específicos que pueden plantear los sistemas de IA.

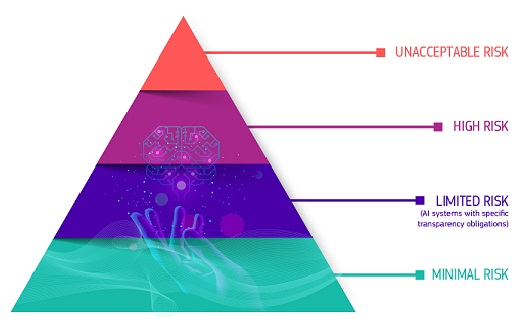

Un enfoque basado en el riesgo

La Ley de IA define cuatro niveles de riesgo para los sistemas de IA:

Riesgo inaceptable

Todos los sistemas de IA considerados una clara amenaza para la seguridad, los medios de subsistencia y los derechos de las personas están prohibidos. La Ley de IA prohíbe ocho prácticas, a saber:

- manipulación y engaño perjudiciales basados en la IA

- explotación perjudicial de vulnerabilidades basada en la IA

- puntuación social

- Evaluación o predicción del riesgo de infracción penal individual

- raspado no dirigido de Internet o material de CCTV para crear o ampliar bases de datos de reconocimiento facial

- Reconocimiento de emociones en lugares de trabajo e instituciones educativas

- categorización biométrica para deducir determinadas características protegidas

- Identificación biométrica remota en tiempo real con fines policiales en espacios de acceso público

Alto riesgo

Los casos de uso de la IA que pueden plantear riesgos graves para la salud, la seguridad o los derechos fundamentales se clasifican como de alto riesgo. Estos casos de uso de alto riesgo incluyen:

- Componentes de seguridad de la IA en infraestructuras críticas (por ejemplo, el transporte), cuyo fallo podría poner en peligro la vida y la salud de los ciudadanos

- Soluciones de IA utilizadas en instituciones educativas, que pueden determinar el acceso a la educación y el curso de la vida profesional de una persona (por ejemplo, puntuación de los exámenes)

- Componentes de seguridad de los productos basados en IA (por ejemplo, aplicación de IA en cirugía asistida por robot)

- Herramientas de IA para el empleo, la gestión de los trabajadores y el acceso al trabajo por cuenta propia (por ejemplo, software de clasificación de CV para la contratación)

- Determinados casos de uso de la IA utilizados para dar acceso a servicios públicos y privados esenciales (por ejemplo, calificación crediticia que niega a los ciudadanos la oportunidad de obtener un préstamo)

- Sistemas de IA utilizados para la identificación biométrica remota, el reconocimiento de emociones y la categorización biométrica (por ejemplo, un sistema de IA para identificar retroactivamente a un ladrón de tiendas)

- Casos de uso de la IA en la aplicación de la ley que pueden interferir con los derechos fundamentales de las personas (por ejemplo, evaluación de la fiabilidad de las pruebas)

- Casos de uso de la IA en la gestión de la migración, el asilo y el control fronterizo (por ejemplo, examen automatizado de las solicitudes de visado)

- Soluciones de IA utilizadas en la administración de justicia y los procesos democráticos (por ejemplo, soluciones de IA para preparar resoluciones judiciales)

Los sistemas de IA de alto riesgo están sujetos a obligaciones estrictas antes de que puedan introducirse en el mercado:

- sistemas adecuados de evaluación y mitigación de riesgos

- alta calidad de los conjuntos de datos que alimentan el sistema para minimizar los riesgos de resultados discriminatorios

- registro de la actividad para garantizar la trazabilidad de los resultados

- documentación detallada que proporcione toda la información necesaria sobre el sistema y su finalidad para que las autoridades evalúen su conformidad

- información clara y adecuada al implementador

- medidas adecuadas de supervisión humana

- alto nivel de robustez, ciberseguridad y precisión

Riesgo de transparencia

Esto se refiere a los riesgos asociados con la necesidad de transparencia en torno al uso de la IA. La Ley de Inteligencia Artificial introduce obligaciones específicas de divulgación para garantizar que los seres humanos estén informados cuando sea necesario para preservar la confianza. Por ejemplo, cuando se utilizan sistemas de IA como los chatbots, los humanos deben ser conscientes de que están interactuando con una máquina para que puedan tomar una decisión informada.

Además, los proveedores de IA generativa deben garantizar que el contenido generado por la IA sea identificable. Además, determinados contenidos generados por IA deben etiquetarse de manera clara y visible, a saber, las falsificaciones profundas y el texto publicado con el fin de informar al público sobre asuntos de interés público.

Riesgo mínimo o nulo

La Ley de IA no introduce normas para la IA que se consideren de riesgo mínimo o nulo. La gran mayoría de los sistemas de IA utilizados actualmente en la UE entran en esta categoría. Esto incluye aplicaciones como videojuegos habilitados para IA o filtros de spam.

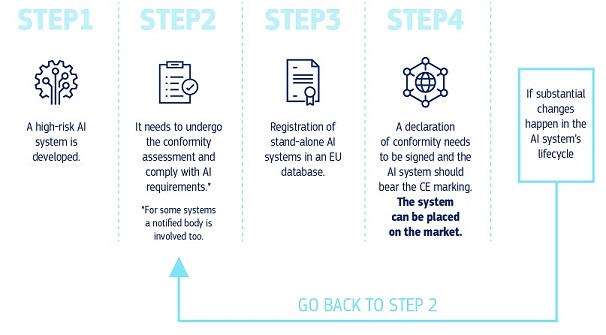

¿Cómo funciona todo esto en la práctica para los proveedores de sistemas de IA de alto riesgo?

¿Cómo funciona todo esto en la práctica para los proveedores de sistemas de IA de alto riesgo?

Una vez que un sistema de IA está en el mercado, las autoridades están a cargo de la vigilancia del mercado, los implementadores garantizan la supervisión y el seguimiento humanos, y los proveedores cuentan con un sistema de seguimiento posterior a la comercialización. Los proveedores y los implementadores también informarán de incidentes graves y fallos de funcionamiento.

Una solución para el uso fiable de grandes modelos de IA

Los modelos de IA de uso general pueden realizar una amplia gama de tareas y se están convirtiendo en la base de muchos sistemas de IA en la UE. Algunos de estos modelos podrían conllevar riesgos sistémicos si son muy capaces o ampliamente utilizados. Para garantizar una IA segura y fiable, la Ley de IA establece normas para los proveedores de dichos modelos. Esto incluye la transparencia y las normas relacionadas con los derechos de autor. Para los modelos que pueden conllevar riesgos sistémicos, los proveedores deben evaluar y mitigar estos riesgos.

Las normas de la Ley de IA sobre IA de uso general entrarán en vigor en agosto de 2025. La Oficina de IA está facilitando la elaboración de un código de buenas prácticas para detallar estas normas. El Código debe representar una herramienta central para que los proveedores demuestren el cumplimiento de la Ley de IA, incorporando prácticas de vanguardia.

Gobernanza y aplicación

La Oficina Europea de IA y las autoridades de los Estados miembros son responsables de aplicar, supervisar y hacer cumplir la Ley de IA. El Consejo de IA, el Comité Científico y el Foro Consultivo dirigen y asesoran la gobernanza de la Ley de IA. Obtenga más información sobre la gobernanza y la aplicación de la Ley de IA.

Próximos pasos

La Ley de IA entró en vigor el 1 de agosto de 2024 y será plenamente aplicable dos años después, el 2 de agosto de 2026, con algunas excepciones:

- prohibiciones y obligaciones de alfabetización en materia de IA que entrarán en vigor a partir del 2 de febrero de 2025

- las normas de gobernanza y las obligaciones relativas a los modelos de IA de uso general serán aplicables a partir del 2 de agosto de 2025;

- las normas para los sistemas de IA de alto riesgo —integrados en productos regulados— tienen un período transitorio ampliado hasta el 2 de agosto de 2027;

Últimas noticias

Informe/Estudio

- 23-09-2024EU study calls for strategic AI adoption to transform public sector services

- 05-04-2024IA para el bien público: Alianza de Investigación UE-EE.UU. en IA para el Bien Público

- 30-11-2023Potencial de Europa en la computación periférica: Apoyo a la innovación industrial a través de proyectos piloto a gran escala

Ficha informativa / Infografía

Contenidos relacionados

Visión general

En detalle

-

La Oficina Europea de IA y las autoridades nacionales de vigilancia del mercado son responsables de...