Akt o umetni inteligenci je prvi pravni okvir o umetni inteligenci doslej, ki obravnava tveganja umetne inteligence in Evropi zagotavlja vodilno vlogo na svetovni ravni.

Akt o umetni inteligenci (Uredba (EU) 2024/1689 o določitvi harmoniziranih pravil o umetni inteligenci) je prvi celovit pravni okvir o umetni inteligenci na svetu. Cilj pravil je spodbujati zaupanja vredno umetno inteligenco v Evropi.

Akt o umetni inteligenci določa jasen sklop pravil, ki temeljijo na tveganju, za razvijalce in uvajalce umetne inteligence v zvezi s posebnimi uporabami umetne inteligence. Akt o umetni inteligenci je del širšega svežnja ukrepov politike za podporo razvoju zaupanja vredne umetne inteligence, ki vključuje tudi inovacijski sveženj za umetno inteligenco, zagon tovarn umetne inteligence in usklajeni načrt za umetno inteligenco. Ti ukrepi skupaj zagotavljajo varnost, temeljne pravice in na človeka osredotočeno umetno inteligenco ter krepijo uvajanje umetne inteligence, naložbe vanjo in inovacije vanjo po vsej EU.

Da bi olajšala prehod na novi regulativni okvir, je Komisija začela izvajati pakt za umetno inteligenco, prostovoljno pobudo, katere namen je podpreti prihodnje izvajanje, sodelovati z deležniki ter ponudnike in uvajalce umetne inteligence iz Evrope in od drugod pozvati, naj vnaprej izpolnijo ključne obveznosti iz akta o umetni inteligenci.

Zakaj potrebujemo pravila o umetni inteligenci?

Akt o umetni inteligenci zagotavlja, da lahko Evropejci zaupajo temu, kar ponuja umetna inteligenca. Čeprav je večina umetnointeligenčnih sistemov omejena na nič tveganja in lahko prispeva k reševanju številnih družbenih izzivov, nekateri umetnointeligenčni sistemi ustvarjajo tveganja, ki jih moramo obravnavati, da bi se izognili neželenim rezultatom.

Pogosto na primer ni mogoče ugotoviti, zakaj je umetnointeligenčni sistem sprejel odločitev ali napoved in sprejel določen ukrep. Zato je morda težko oceniti, ali je bil nekdo neupravičeno prikrajšan, na primer v odločitvi o zaposlitvi ali v vlogi za javnokoristno shemo.

Čeprav obstoječa zakonodaja zagotavlja določeno zaščito, ne zadostuje za obravnavanje posebnih izzivov, ki jih lahko prinesejo umetnointeligenčni sistemi.

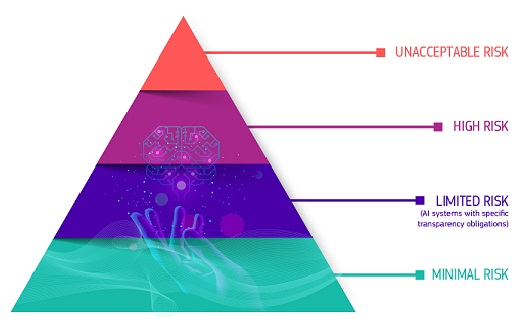

Pristop, ki temelji na tveganju

Akt o umetni inteligenci opredeljuje štiri ravni tveganja za umetnointeligenčne sisteme:

Nesprejemljivo tveganje

Vsi umetnointeligenčni sistemi, ki veljajo za očitno grožnjo varnosti, možnostim preživljanja in pravicam ljudi, so prepovedani. Akt o umetni inteligenci prepoveduje osem praks, in sicer:

- škodljive manipulacije in prevare, ki temeljijo na umetni inteligenci

- škodljivo izkoriščanje ranljivosti, ki temelji na umetni inteligenci

- socialno točkovanje

- Ocena ali napoved tveganja posameznega kaznivega dejanja

- neciljno strganje interneta ali gradiva CCTV za ustvarjanje ali razširitev podatkovnih zbirk za prepoznavanje obrazov

- Priznavanje čustev na delovnih mestih in v izobraževalnih ustanovah

- biometrična kategorizacija za ugotavljanje nekaterih zaščitenih značilnosti

- biometrična identifikacija na daljavo v realnem času za namene preprečevanja, odkrivanja in preiskovanja kaznivih dejanj v javno dostopnih prostorih

Veliko tveganje

Primeri uporabe umetne inteligence, ki lahko pomenijo resno tveganje za zdravje, varnost ali temeljne pravice, so razvrščeni kot primeri velikega tveganja. Ti primeri uporabe z visokim tveganjem vključujejo:

- Varnostne komponente umetne inteligence v kritičnih infrastrukturah (npr. prometu), katerih nedelovanje bi lahko ogrozilo življenje in zdravje državljanov

- Rešitve umetne inteligence, ki se uporabljajo v izobraževalnih ustanovah in lahko določajo dostop do izobraževanja in potek posameznikovega poklicnega življenja (npr. točkovanje izpitov)

- Varnostne komponente proizvodov, ki temeljijo na umetni inteligenci (npr. uporaba umetne inteligence v robotsko podprti kirurgiji)

- Orodja umetne inteligence za zaposlovanje, upravljanje delavcev in dostop do samozaposlitve (npr. programska oprema za razvrščanje življenjepisov pri zaposlovanju)

- Nekateri primeri uporabe umetne inteligence, ki se uporabljajo za omogočanje dostopa do osnovnih zasebnih in javnih storitev (npr. kreditno točkovanje, ki državljanom onemogoča pridobitev posojila)

- umetnointeligenčni sistemi, ki se uporabljajo za biometrično identifikacijo na daljavo, prepoznavanje čustev in biometrično kategorizacijo (npr. umetnointeligenčni sistem za retroaktivno identifikacijo tatov)

- Primeri uporabe umetne inteligence pri preprečevanju, odkrivanju in preiskovanju kaznivih dejanj, ki lahko posegajo v temeljne pravice ljudi (npr. ocena zanesljivosti dokazov)

- Primeri uporabe umetne inteligence pri upravljanju migracij, azila in nadzora meja (npr. avtomatizirano obravnavanje vlog za izdajo vizuma)

- Rešitve umetne inteligence, ki se uporabljajo v pravosodju in demokratičnih procesih (npr. rešitve umetne inteligence za pripravo sodnih odločb)

Za umetnointeligenčne sisteme velikega tveganja veljajo stroge obveznosti, preden se lahko dajo na trg:

- ustrezni sistemi za oceno in zmanjšanje tveganja

- visokokakovostni nabori podatkov, ki vnašajo podatke v sistem, da se čim bolj zmanjša tveganje diskriminatornih rezultatov

- beleženje dejavnosti za zagotovitev sledljivosti rezultatov

- podrobno dokumentacijo z vsemi potrebnimi informacijami o sistemu in njegovem namenu, da lahko organi ocenijo njegovo skladnost;

- jasne in ustrezne informacije za uvajalca

- ustrezni ukrepi za človekov nadzor

- visoka raven robustnosti, kibernetske varnosti in natančnosti

Tveganje v zvezi s preglednostjo

To se nanaša na tveganja, povezana s potrebo po preglednosti v zvezi z uporabo umetne inteligence. Akt o umetni inteligenci uvaja posebne obveznosti razkritja, da se zagotovi obveščenost ljudi, kadar je to potrebno za ohranitev zaupanja. Na primer, pri uporabi umetnointeligenčnih sistemov, kot so klepetalni boti, bi bilo treba ljudi opozoriti, da so v stiku s strojem, da lahko sprejmejo informirano odločitev.

Poleg tega morajo ponudniki generativne umetne inteligence zagotoviti, da je mogoče prepoznati vsebine, ustvarjene z umetno inteligenco. Poleg tega bi morale biti nekatere vsebine, ustvarjene z umetno inteligenco, jasno in vidno označene, in sicer globoki ponaredki in besedilo, objavljeno z namenom obveščanja javnosti o zadevah javnega interesa.

Minimalno tveganje ali brez tveganja

Akt o umetni inteligenci ne uvaja pravil za umetno inteligenco, ki se šteje za minimalno ali brez tveganja. Velika večina umetnointeligenčnih sistemov, ki se trenutno uporabljajo v EU, spada v to kategorijo. To vključuje aplikacije, kot so videoigre, ki temeljijo na umetni inteligenci, ali filtri za neželeno pošto.

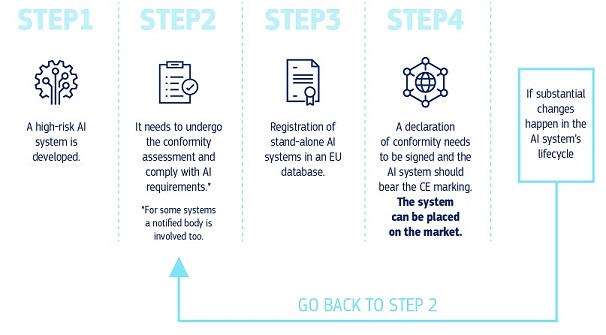

Kako vse to deluje v praksi za ponudnike umetnointeligenčnih sistemov velikega tveganja?

Kako vse to deluje v praksi za ponudnike umetnointeligenčnih sistemov velikega tveganja?

Ko je umetnointeligenčni sistem na trgu, so organi odgovorni za nadzor trga, uvajalci zagotavljajo človeški nadzor in spremljanje, ponudniki pa imajo vzpostavljen sistem spremljanja po dajanju na trg. Ponudniki in uvajalci bodo poročali tudi o resnih incidentih in okvarah.

Rešitev za zaupanja vredno uporabo velikih modelov umetne inteligence

Modeli umetne inteligence za splošne namene lahko opravljajo najrazličnejše naloge in postajajo podlaga za številne umetnointeligenčne sisteme v EU. Nekateri od teh modelov bi lahko pomenili sistemska tveganja, če so zelo zmogljivi ali se široko uporabljajo. Za zagotovitev varne in zaupanja vredne umetne inteligence akt o umetni inteligenci določa pravila za ponudnike takih modelov. To vključuje preglednost in pravila, povezana z avtorskimi pravicami. Za modele, ki lahko nosijo sistemska tveganja, bi morali ponudniki ta tveganja oceniti in zmanjšati.

Pravila akta o umetni inteligenci za splošne namene bodo začela veljati avgusta 2025. Urad za umetno inteligenco olajšuje pripravo kodeksa ravnanja za podrobno določitev teh pravil. Kodeks bi moral biti osrednje orodje, s katerim lahko ponudniki dokažejo skladnost z aktom o umetni inteligenci in ki vključuje najsodobnejše prakse.

Upravljanje in izvajanje

Evropski urad za umetno inteligenco in organi držav članic so odgovorni za izvajanje, nadzor in izvrševanje akta o umetni inteligenci. Odbor za umetno inteligenco, znanstveni odbor in svetovalni forum usmerjajo upravljanje akta o umetni inteligenci in mu svetujejo. Več podrobnosti o upravljanju in izvrševanju akta o umetni inteligenci.

Naslednji koraki

Akt o umetni inteligenci je začel veljati 1. avgusta 2024 in se bo v celoti uporabljal dve leti pozneje, 2. avgusta 2026, z nekaterimi izjemami:

- prepovedi in obveznosti glede pismenosti na področju umetne inteligence, ki se bodo začele uporabljati 2. februarja 2025

- pravila upravljanja in obveznosti za modele umetne inteligence za splošne namene se začnejo uporabljati 2. avgusta 2025.

- pravila za umetnointeligenčne sisteme velikega tveganja, vgrajene v regulirane proizvode, imajo podaljšano prehodno obdobje do 2. avgusta 2027;

Zadnje novice

Politike in zakonodaja

- 28-03-2025Delovni program za obdobje 2025–2027 programa za digitalno Evropo (DIGITAL)

- 11-03-2025Objavljen tretji osnutek splošnega kodeksa ravnanja na področju umetne inteligence, ki so ga pripravili neodvisni strokovnjaki

- 11-03-2025Komisija sprejme izvedbeni akt za ustanovitev znanstvenega odbora na podlagi akta o umetni inteligenci

Publikacija

- 23-09-2024EU study calls for strategic AI adoption to transform public sector services

- 05-04-2024Umetna inteligenca za javno dobro: Zveza EU-ZDA za raziskave na področju umetne inteligence za javno dobro

- 30-11-2023Potencial Evrope pri računalništvu na robu: Podpiranje industrijskih inovacij z obsežnimi pilotnimi projekti

Informativni pregled/infografika

Brošura

- 04-02-2025Živi repozitorij za spodbujanje učenja in izmenjave na področju pismenosti na področju umetne inteligence

- 04-03-2024Obzorje Evropa: novi projekti na področju umetne inteligence, podatkov in robotike – izdaja 2024

- 14-04-2021Novi projekti na področju robotike v okviru programa Obzorje 2020 za leto 2021

Povezane vsebine

Širša slika

Podrobnejše informacije

-

Evropski urad za umetno inteligenco in nacionalni organi za nadzor trga so odgovorni za izvajanje...