O Regulamento Inteligência Artificial é o primeiro quadro jurídico em matéria de IA, que aborda os riscos da IA e posiciona a Europa para desempenhar um papel de liderança a nível mundial.

O Regulamento Inteligência Artificial (Regulamento (UE) 2024/1689 que estabelece regras harmonizadas em matéria de inteligência artificial) é o primeiro quadro jurídico abrangente em matéria de IA a nível mundial. O objetivo das regras é promover uma IA de confiança na Europa.

O Regulamento Inteligência Artificial estabelece um conjunto claro de regras baseadas no risco para os criadores e implantadores de IA no que diz respeito a utilizações específicas da IA. O Regulamento Inteligência Artificial faz parte de um pacote mais vasto de medidas políticas destinadas a apoiar o desenvolvimento de uma IA de confiança, que inclui igualmente o pacote de inovação no domínio da IA, o lançamento de fábricas de IA e o Plano Coordenado para a IA. Em conjunto, estas medidas garantem a segurança, os direitos fundamentais e uma IA centrada no ser humano e reforçam a adoção, o investimento e a inovação no domínio da IA em toda a UE.

Para facilitar a transição para o novo quadro regulamentar, a Comissão lançou o Pacto para a IA, uma iniciativa voluntária que visa apoiar a futura aplicação, dialogar com as partes interessadas e convidar os fornecedores e implantadores de IA da Europa e de outros países a cumprirem antecipadamente as principais obrigações do Regulamento Inteligência Artificial.

Por que razão são necessárias regras em matéria de IA?

O Regulamento Inteligência Artificial garante que os europeus podem confiar no que a IA tem para oferecer. Embora a maioria dos sistemas de IA seja limitada a nenhum risco e possa contribuir para resolver muitos desafios societais, certos sistemas de IA criam riscos que temos de enfrentar para evitar resultados indesejáveis.

Por exemplo, muitas vezes não é possível descobrir por que motivo um sistema de IA tomou uma decisão ou uma previsão e tomou uma determinada ação. Assim, pode tornar-se difícil avaliar se alguém foi injustamente prejudicado, como numa decisão de contratação ou num pedido de um regime de utilidade pública.

Embora a legislação em vigor proporcione alguma proteção, é insuficiente para dar resposta aos desafios específicos que os sistemas de IA podem trazer.

Uma abordagem baseada no risco

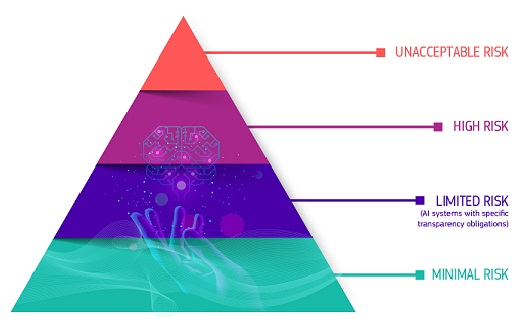

O Regulamento Inteligência Artificial define quatro níveis de risco para os sistemas de IA:

Risco inaceitável

Todos os sistemas de IA considerados uma clara ameaça à segurança, aos meios de subsistência e aos direitos das pessoas são proibidos. O Regulamento Inteligência Artificial proíbe oito práticas, a saber:

- manipulação e engano prejudiciais com base na IA

- exploração nociva de vulnerabilidades com base na IA

- pontuação social

- Avaliação ou previsão do risco de uma infração penal individual

- Raspagem não direcionada de material da Internet ou CCTV para criar ou expandir bases de dados de reconhecimento facial

- reconhecimento das emoções nos locais de trabalho e nas instituições de ensino

- categorização biométrica para deduzir determinadas características protegidas

- Identificação biométrica à distância em tempo real para fins de aplicação da lei em espaços acessíveis ao público

Risco elevado

Os casos de utilização da IA que possam representar riscos graves para a saúde, a segurança ou os direitos fundamentais são classificados como de risco elevado. Estes casos de uso de alto risco incluem:

- Componentes de segurança da IA em infraestruturas críticas (por exemplo, transportes), cuja falha pode pôr em risco a vida e a saúde dos cidadãos

- Soluções de IA utilizadas em instituições de ensino, que podem determinar o acesso à educação e ao curso da vida profissional de alguém (por exemplo, pontuação dos exames)

- Componentes de segurança de produtos baseados em IA (por exemplo, aplicação de IA em cirurgia assistida por robôs)

- Ferramentas de IA para o emprego, a gestão dos trabalhadores e o acesso ao trabalho por conta própria (por exemplo, software de triagem de CV para recrutamento)

- Determinados casos de utilização da IA utilizados para dar acesso a serviços públicos e privados essenciais (por exemplo, pontuação de crédito que nega aos cidadãos a oportunidade de obter um empréstimo)

- Sistemas de IA utilizados para identificação biométrica à distância, reconhecimento de emoções e categorização biométrica (por exemplo, sistema de IA para identificar retroativamente um ladrão)

- Casos de utilização da IA na aplicação da lei que possam interferir com os direitos fundamentais das pessoas (por exemplo, avaliação da fiabilidade das provas)

- Casos de utilização da IA na gestão da migração, do asilo e do controlo das fronteiras (por exemplo, análise automatizada dos pedidos de visto)

- Soluções de IA utilizadas na administração da justiça e nos processos democráticos (por exemplo, soluções de IA para preparar decisões judiciais)

Os sistemas de IA de risco elevado estão sujeitos a obrigações rigorosas antes de poderem ser colocados no mercado:

- sistemas adequados de avaliação e atenuação dos riscos

- elevada qualidade dos conjuntos de dados que alimentam o sistema, a fim de minimizar os riscos de resultados discriminatórios

- registo da atividade para assegurar a rastreabilidade dos resultados

- Documentação pormenorizada que forneça todas as informações necessárias sobre o sistema e a sua finalidade para que as autoridades possam avaliar a sua conformidade

- Informações claras e adequadas ao responsável pela implantação

- Medidas adequadas de supervisão humana

- elevado nível de robustez, cibersegurança e exatidão

Risco de transparência

Trata-se dos riscos associados à necessidade de transparência em torno da utilização da IA. O Regulamento Inteligência Artificial introduz obrigações de divulgação específicas para assegurar que os seres humanos são informados sempre que necessário para preservar a confiança. Por exemplo, ao utilizar sistemas de IA como os robôs de conversação, os seres humanos devem ser informados de que estão a interagir com uma máquina para poderem tomar uma decisão informada.

Além disso, os fornecedores de IA generativa têm de assegurar que os conteúdos gerados por IA são identificáveis. Além disso, determinados conteúdos gerados por IA devem ser rotulados de forma clara e visível, nomeadamente falsificações profundas e textos publicados com o objetivo de informar o público sobre questões de interesse público.

Risco mínimo ou nulo

O Regulamento Inteligência Artificial não introduz regras para a IA que sejam consideradas de risco mínimo ou nulo. A grande maioria dos sistemas de IA atualmente utilizados na UE insere-se nesta categoria. Isto inclui aplicações como jogos de vídeo com IA ou filtros de spam.

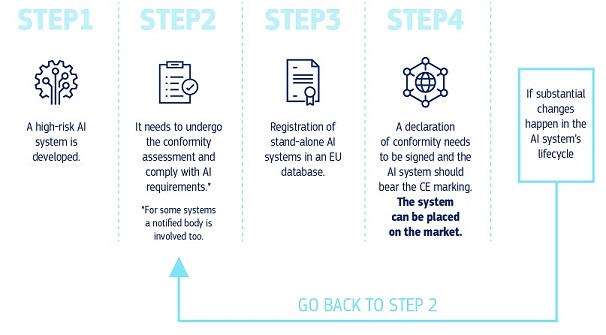

Como é que tudo isto funciona na prática para os fornecedores de sistemas de IA de risco elevado?

Como é que tudo isto funciona na prática para os fornecedores de sistemas de IA de risco elevado?

Quando um sistema de IA está no mercado, as autoridades são responsáveis pela fiscalização do mercado, os responsáveis pela implantação asseguram a supervisão e o acompanhamento humanos e os fornecedores dispõem de um sistema de monitorização pós-comercialização. Fornecedores e implantadores também relatarão incidentes graves e mau funcionamento.

Uma solução para a utilização fiável de grandes modelos de IA

Os modelos de IA de finalidade geral podem desempenhar uma vasta gama de tarefas e estão a tornar-se a base de muitos sistemas de IA na UE. Alguns destes modelos podem acarretar riscos sistémicos se forem muito capazes ou amplamente utilizados. A fim de garantir uma IA segura e fiável, o Regulamento Inteligência Artificial estabelece regras para os fornecedores desses modelos. Tal inclui regras em matéria de transparência e de direitos de autor. No caso dos modelos que possam comportar riscos sistémicos, os prestadores devem avaliar e atenuar esses riscos.

As regras do Regulamento Inteligência Artificial relativas à IA de finalidade geral entrarão em vigor em agosto de 2025. O Serviço IA está a facilitar a elaboração de um código de conduta para pormenorizar estas regras. O Código deve representar um instrumento central para os fornecedores demonstrarem a conformidade com o Regulamento Inteligência Artificial, incorporando práticas de ponta.

Governação e execução

O Serviço Europeu para a IA e as autoridades dos Estados-Membros são responsáveis pela aplicação, supervisão e execução do Regulamento Inteligência Artificial. O Comité para a IA, o Painel Científico e o Fórum Consultivo orientam e aconselham a governação do Regulamento Inteligência Artificial. Mais informações sobre a governação e a aplicação do Regulamento Inteligência Artificial.

Próximas etapas

O Regulamento Inteligência Artificial entrou em vigor em 1 de agosto de 2024 e será plenamente aplicável dois anos mais tarde, em 2 de agosto de 2026, com algumas exceções:

- as proibições e as obrigações em matéria de literacia no domínio da IA entraram em vigor em 2 de fevereiro de 2025

- as regras de governação e as obrigações relativas aos modelos de IA de finalidade geral tornam-se aplicáveis em 2 de agosto de 2025

- as regras aplicáveis aos sistemas de IA de risco elevado - incorporados em produtos regulamentados - têm um período de transição alargado até 2 de agosto de 2027

Últimas notícias

Política e legislação

- 11-03-2025Publicação do terceiro projeto do Código de Conduta para a Inteligência Artificial de Finalidade Geral, elaborado por peritos independentes

- 11-03-2025Comissão adota ato de execução para criar um painel científico ao abrigo do Regulamento Inteligência Artificial

- 28-02-2025Segunda reunião do Conselho de Comércio e Tecnologia Índia-UE – Declaração conjunta

Relatório/estudo

Ficha de informação/infografia

Conteúdo relacionado

Visão geral

Em pormenor

-

O Serviço Europeu para a IA e as autoridades nacionais de fiscalização do mercado são responsáveis...