Akt o umjetnoj inteligenciji prvi je pravni okvir za umjetnu inteligenciju koji se bavi rizicima umjetne inteligencije i pozicionira Europu da preuzme vodeću ulogu na globalnoj razini.

Akt o umjetnoj inteligenciji (Uredba (EU) 2024/1689 o utvrđivanju usklađenih pravila o umjetnoj inteligenciji) prvi je sveobuhvatni pravni okvir za umjetnu inteligenciju u svijetu. Cilj je pravila poticati pouzdanu umjetnu inteligenciju u Europi.

Aktom o umjetnoj inteligenciji utvrđuje se jasan skup pravila utemeljenih na riziku za razvojne programere i subjekte za uvođenje umjetne inteligencije u pogledu posebnih primjena umjetne inteligencije. Akt o umjetnoj inteligenciji dio je šireg paketa mjera politike za potporu razvoju pouzdane umjetne inteligencije, koji uključuje i paket za inovacije u području umjetne inteligencije, pokretanje tvornica umjetne inteligencije i Koordinirani plan za umjetnu inteligenciju. Tim se mjerama zajedno jamče sigurnost, temeljna prava i antropocentrična umjetna inteligencija te jačaju prihvaćanje, ulaganja i inovacije u području umjetne inteligencije u cijelom EU-u.

Kako bi olakšala prelazak na novi regulatorni okvir, Komisija je pokrenula Pakt o umjetnoj inteligenciji, dobrovoljnu inicijativu kojom se nastoji poduprijeti buduća provedba, surađivati s dionicima i pozvati dobavljače i subjekte za uvođenje umjetne inteligencije iz Europe i šire da unaprijed ispune ključne obveze iz Akta o umjetnoj inteligenciji.

Zašto su nam potrebna pravila o umjetnoj inteligenciji?

Aktom o umjetnoj inteligenciji Europljanima se osigurava povjerenje u ono što umjetna inteligencija nudi. Iako većina UI sustava ne predstavlja nikakav rizik i može doprinijeti rješavanju mnogih društvenih izazova, određeni UI sustavi stvaraju rizike koje moramo ukloniti kako bismo izbjegli neželjene ishode.

Na primjer, često nije moguće saznati zašto je UI sustav donio odluku ili predvidio i poduzeo određenu radnju. Stoga može biti teško procijeniti je li netko nepravedno stavljen u nepovoljniji položaj, primjerice u odluci o zapošljavanju ili u zahtjevu za sustav javnih naknada.

Iako se postojećim zakonodavstvom pruža određena zaštita, ono nije dovoljno za rješavanje posebnih izazova koje sustavi umjetne inteligencije mogu donijeti.

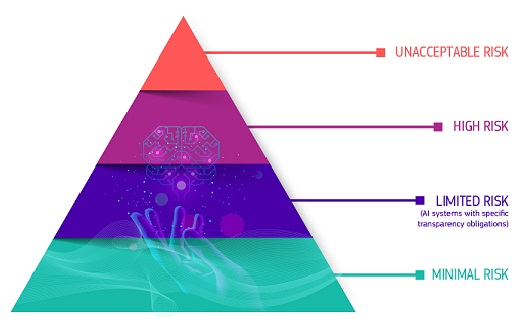

Pristup koji se temelji na riziku

Aktom o umjetnoj inteligenciji definirane su četiri razine rizika za UI sustave:

Neprihvatljivi rizik

Zabranjeni su svi sustavi umjetne inteligencije koji se smatraju jasnom prijetnjom sigurnosti, sredstvima za život i pravima ljudi. Aktom o umjetnoj inteligenciji zabranjuje se osam praksi, i to:

- štetne manipulacije i obmane koje se temelje na umjetnoj inteligenciji

- štetno iskorištavanje ranjivosti koje se temelji na umjetnoj inteligenciji

- društveno bodovanje

- Procjena ili predviđanje rizika pojedinačnog kaznenog djela

- neciljano struganje interneta ili CCTV materijala radi stvaranja ili proširenja baza podataka za prepoznavanje lica

- prepoznavanje emocija na radnim mjestima i u obrazovnim ustanovama

- biometrijska kategorizacija kako bi se izvele određene zaštićene značajke

- daljinska biometrijska identifikacija u stvarnom vremenu za potrebe kaznenog progona na javnim mjestima

Visok rizik

Slučajevi uporabe umjetne inteligencije koji mogu predstavljati ozbiljan rizik za zdravlje, sigurnost ili temeljna prava klasificirani su kao visokorizični. Ti slučajevi visokorizične uporabe uključuju:

- sigurnosne komponente umjetne inteligencije u kritičnim infrastrukturama (npr. promet), čiji bi neuspjeh mogao ugroziti život i zdravlje građana

- rješenja umjetne inteligencije koja se upotrebljavaju u obrazovnim ustanovama, a koja mogu odrediti pristup obrazovanju i tijek nečijeg profesionalnog života (npr. bodovanje ispita)

- Sigurnosni sastavni dijelovi proizvoda koji se temelje na umjetnoj inteligenciji (npr. primjena umjetne inteligencije u kirurškim zahvatima uz pomoć robota)

- Alati umjetne inteligencije za zapošljavanje, upravljanje radnicima i pristup samozapošljavanju (npr. softver za razvrstavanje životopisa za zapošljavanje)

- Određeni slučajevi upotrebe umjetne inteligencije koji se upotrebljavaju kako bi se omogućio pristup osnovnim privatnim i javnim uslugama (npr. ocjenjivanje kreditne sposobnosti kojim se građanima uskraćuje mogućnost dobivanja zajma)

- UI sustavi koji se upotrebljavaju za daljinsku biometrijsku identifikaciju, prepoznavanje emocija i biometrijsku kategorizaciju (npr. UI sustav za retroaktivnu identifikaciju kradljivaca u trgovini)

- Slučajevi upotrebe umjetne inteligencije u tijelima kaznenog progona koji mogu utjecati na temeljna prava ljudi (npr. evaluacija pouzdanosti dokaza)

- Slučajevi upotrebe umjetne inteligencije u upravljanju migracijama, azilom i granicama (npr. automatizirano razmatranje zahtjeva za vizu)

- rješenja umjetne inteligencije koja se upotrebljavaju u pravosuđu i demokratskim procesima (npr. rješenja umjetne inteligencije za pripremu sudskih presuda)

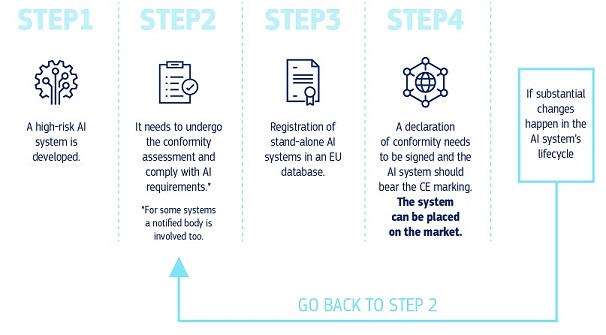

Visokorizični UI sustavi podliježu strogim obvezama prije nego što se mogu staviti na tržište:

- odgovarajući sustavi za procjenu i ublažavanje rizika

- visoka kvaliteta skupova podataka koji se unose u sustav kako bi se rizik od diskriminirajućih ishoda sveo na najmanju moguću mjeru

- evidentiranje aktivnosti kako bi se osigurala sljedivost rezultata

- detaljna dokumentacija sa svim potrebnim informacijama o sustavu i njegovoj svrsi kako bi nadležna tijela mogla procijeniti njegovu usklađenost

- jasne i odgovarajuće informacije subjektu koji primjenjuje sustav

- odgovarajuće mjere ljudskog nadzora

- visoka razina otpornosti, kibersigurnosti i točnosti

Rizik transparentnosti

To se odnosi na rizike povezane s potrebom za transparentnošću u pogledu upotrebe umjetne inteligencije. Aktom o umjetnoj inteligenciji uvode se posebne obveze otkrivanja informacija kako bi se osiguralo da su ljudi informirani kada je to potrebno za očuvanje povjerenja. Na primjer, pri upotrebi sustava umjetne inteligencije kao što su chatbotovi ljudi bi trebali biti svjesni da su u interakciji sa strojem kako bi mogli donijeti informiranu odluku.

Nadalje, dobavljači generativne umjetne inteligencije moraju osigurati da se sadržaj stvoren umjetnom inteligencijom može identificirati. Osim toga, određeni sadržaj stvoren umjetnom inteligencijom trebao bi biti jasno i vidljivo označen, odnosno uvjerljiv krivotvoreni sadržaj (deep fake) i tekst objavljen u svrhu informiranja javnosti o pitanjima od javnog interesa.

Minimalan ili nikakav rizik

Aktom o umjetnoj inteligenciji ne uvode se pravila za umjetnu inteligenciju koja se smatra minimalnom ili nikakvom opasnošću. Velika većina UI sustava koji se trenutačno upotrebljavaju u EU-u pripada toj kategoriji. To uključuje aplikacije kao što su videoigre omogućene umjetnom inteligencijom ili filtri za neželjenu poštu.

Kako sve to funkcionira u praksi za dobavljače visokorizičnih UI sustava?

Kako sve to funkcionira u praksi za dobavljače visokorizičnih UI sustava?

Nakon što se UI sustav stavi na tržište, nadležna tijela zadužena su za nadzor tržišta, subjekti za uvođenje osiguravaju ljudski nadzor i praćenje, a dobavljači imaju uspostavljen sustav praćenja nakon stavljanja na tržište. Pružatelji i subjekti za uvođenje također će prijaviti ozbiljne incidente i neispravnosti.

Rješenje za pouzdanu upotrebu velikih modela umjetne inteligencije

Modeli umjetne inteligencije opće namjene mogu obavljati širok raspon zadaća i postaju temelj mnogih sustava umjetne inteligencije u EU-u. Neki od tih modela mogli bi predstavljati sistemske rizike ako su vrlo sposobni ili u širokoj primjeni. Kako bi se osigurala sigurna i pouzdana umjetna inteligencija, Aktom o umjetnoj inteligenciji utvrđuju se pravila za dobavljače takvih modela. To uključuje transparentnost i pravila povezana s autorskim pravima. Kad je riječ o modelima koji mogu uključivati sistemske rizike, pružatelji bi trebali procijeniti i ublažiti te rizike.

Pravila Akta o umjetnoj inteligenciji o umjetnoj inteligenciji opće namjene stupit će na snagu u kolovozu 2025. Ured za umjetnu inteligenciju olakšava izradu Kodeksa dobre prakse kako bi se detaljno utvrdila ta pravila. Kodeks bi trebao biti središnji alat za dobavljače kako bi dokazali usklađenost s Aktom o umjetnoj inteligenciji i uključivati najsuvremenije prakse.

Upravljanje i provedba

Europski ured za umjetnu inteligenciju i tijela država članica odgovorni su za provedbu, nadzor i izvršenje Akta o umjetnoj inteligenciji. Odbor za umjetnu inteligenciju, znanstveni odbor i Savjetodavni forum usmjeravaju i savjetuju upravljanje Aktom o umjetnoj inteligenciji. Saznajte više pojedinosti o upravljanju Aktom o umjetnoj inteligenciji i njegovoj provedbi.

Sljedeći koraci

Akt o umjetnoj inteligenciji stupio je na snagu 1. kolovoza 2024. i u potpunosti će se primjenjivati dvije godine kasnije, 2. kolovoza 2026., uz neke iznimke:

- zabrane i obveze u pogledu pismenosti u području umjetne inteligencije počele su se primjenjivati 2. veljače 2025.

- pravila upravljanja i obveze za UI modele opće namjene počinju se primjenjivati 2. kolovoza 2025.

- pravila za visokorizične UI sustave ugrađene u regulirane proizvode imaju produljeno prijelazno razdoblje do 2. kolovoza 2027.

Najnovije vijesti

Politika i zakonodavstvo

- 11-03-2025Objavljen treći nacrt Kodeksa dobre prakse u području umjetne inteligencije opće namjene, koji su sastavili neovisni stručnjaci

- 11-03-2025Komisija donosi provedbeni akt o osnivanju znanstvenog panela na temelju Akta o umjetnoj inteligenciji

- 28-02-2025Drugi sastanak Vijeća za trgovinu i tehnologiju Indije i EU-a – zajednička izjava

Izvješće/studija

- 23-09-2024EU study calls for strategic AI adoption to transform public sector services

- 05-04-2024Umjetna inteligencija za javno dobro: Istraživački savez EU-a i SAD-a u području umjetne inteligencije za javno dobro

- 30-11-2023Potencijal Europe u računalstvu na rubu mreže: Potpora industrijskim inovacijama putem velikih pilot-projekata

Informativni članak / infografika

Povezani sadržaj

Šira slika

Dublji pogled

-

Europski ured za umjetnu inteligenciju i nacionalna tijela za nadzor tržišta odgovorni su za...